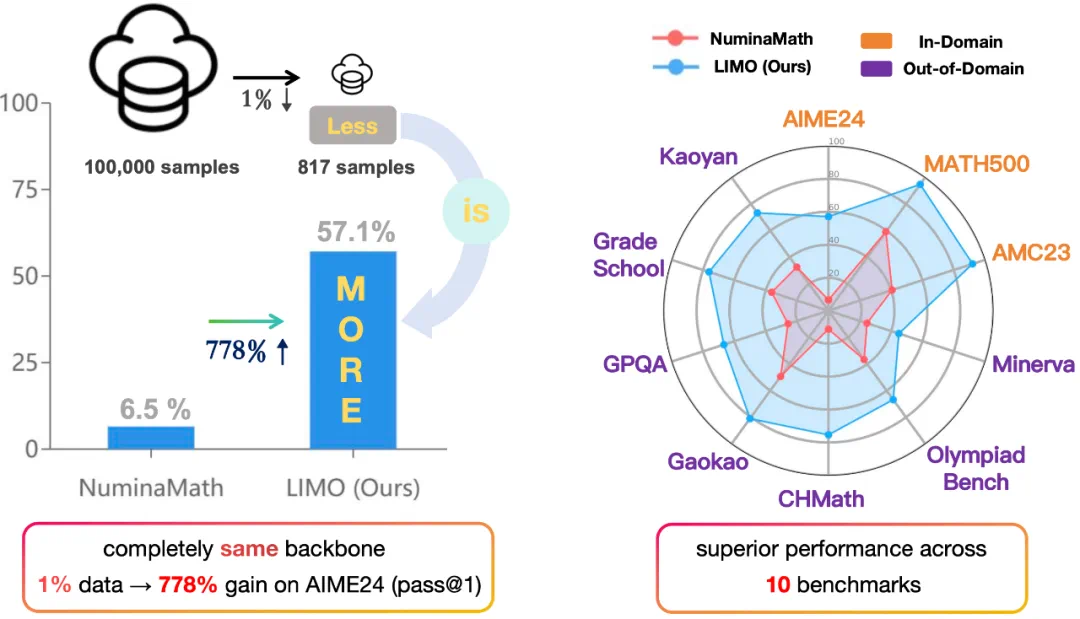

在人工智能领域,深度学习与强化学习(RL)的每一次进步都伴随着对资源的大量需求。然而,上海交通大学的一项最新研究工作犹如一股清流,提出了一个革命性的概念——通过仅仅817个样本,就能激发出相当于常规方法7倍的推理性能。这一发现挑战了长久以来在强化学习领域盛行的“规模即正义”范式,引入了一种名为「少即是多」的全新定律。研究团队展示了一种精妙的算法优化策略,它不仅减少了对大规模数据集的依赖,还显著提升了学习效率和性能,为AI领域的研究者们提供了思考的新方向。这项工作不仅对资源受限环境下的AI应用具有重大意义,也促使我们重新审视高效学习与泛化能力的边界,预示着未来AI发展或将迎来更加智能、高效的纪元。

上海交大最新研究颠覆传统认知:只需817个样本,ai数学推理能力即可超越众多顶尖模型!这项名为limo(lessismoreforreasoning)的研究成果,挑战了“更大即更强”的行业共识,证明了高质量小样本数据在激发大模型推理能力方面的巨大潜力。

一、挑战规模竞赛:激活模型潜能

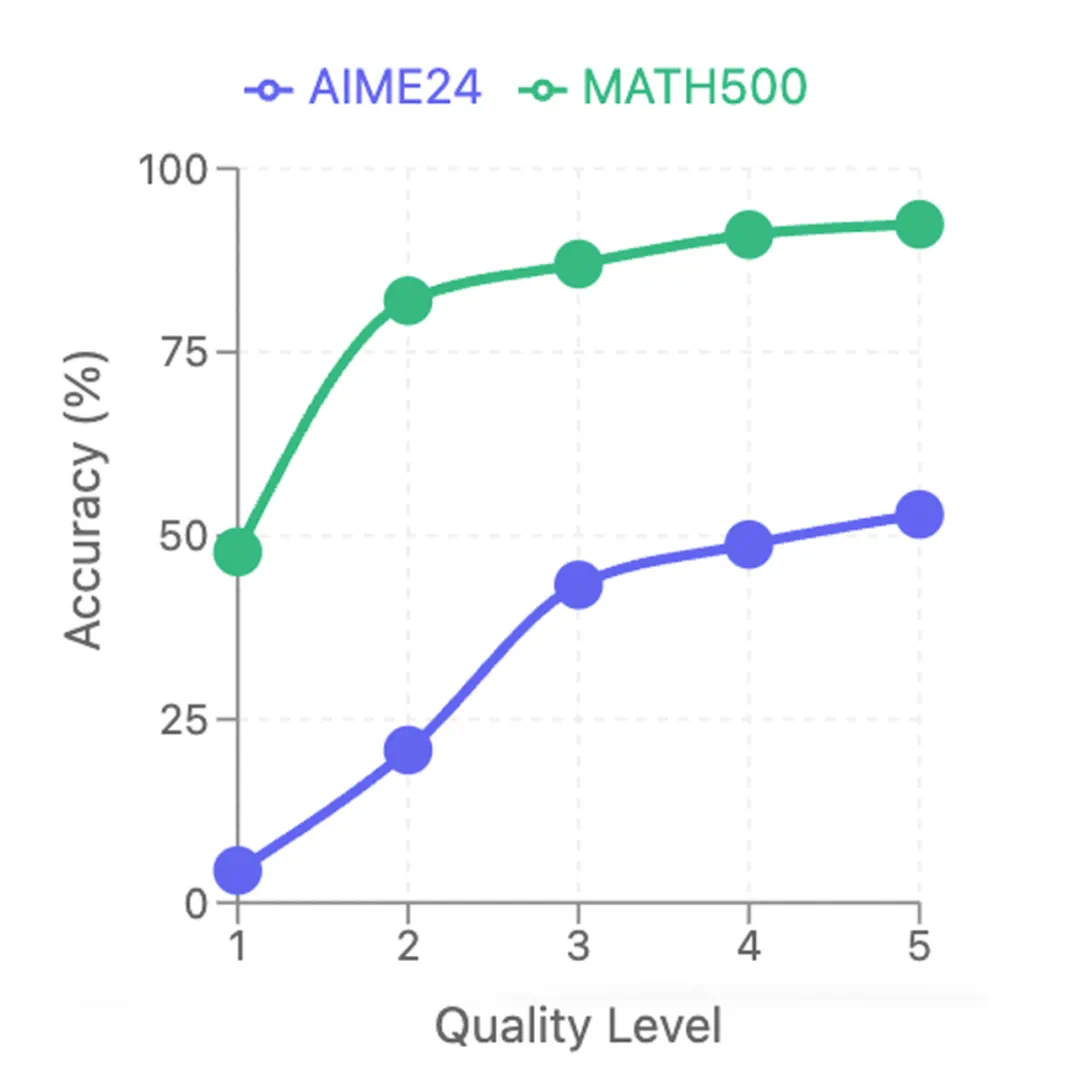

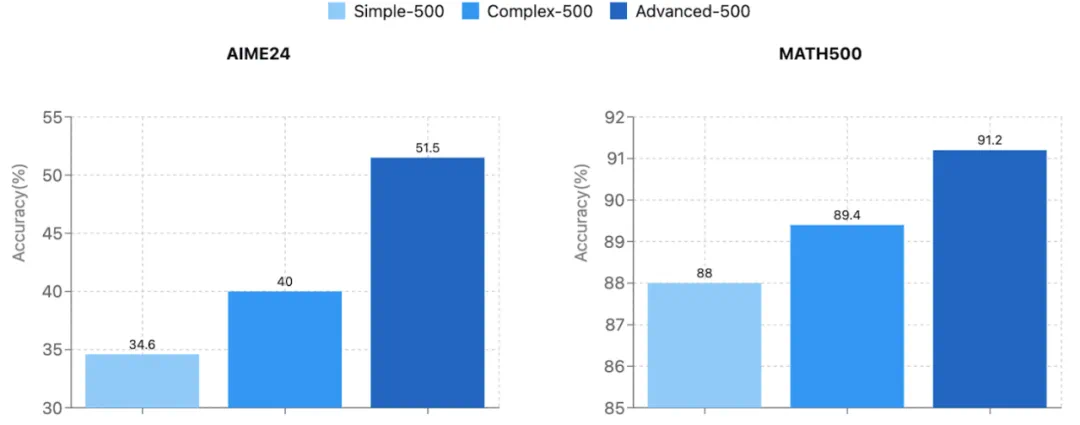

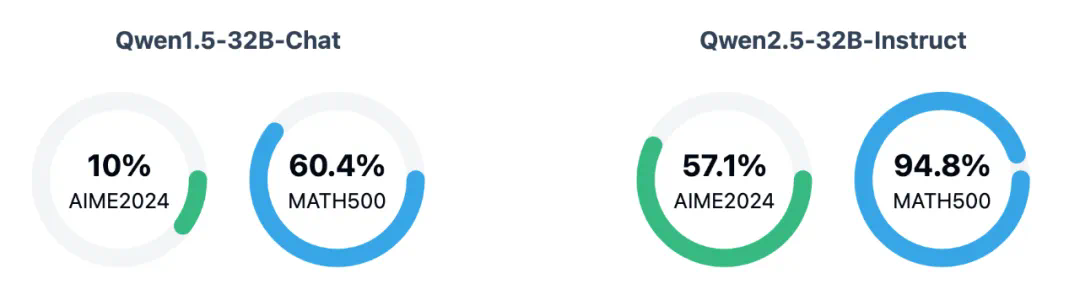

在AI数学推理领域,普遍认为需要海量数据和复杂的强化学习才能取得突破。然而,LIMO研究指出,大模型的数学能力可能早已存在,关键在于如何有效“唤醒”它。这项研究仅用817个精心设计的样本,通过简单的监督微调,就使模型在数学竞赛级别的题目上超越了众多使用十万级数据训练的先进模型,例如o1-preview和QwQ。

二、少即是多:从对齐到推理的范式转变

LIMO延续了此前LIMA(LessIsMoreforAlignment)的研究理念,即在特定任务中,少量高质量数据即可取得显著效果。但将此应用于数学推理领域面临更大挑战。LIMO的成功,归功于两个关键因素:

知识基础革命:现代LLM在预训练阶段已掌握海量数学知识。 推理计算革命:长推理链与模型推理能力密切相关。LIMO假设:在知识基础足够完善的前提下,少量高质量样本,通过推理链即可激活模型的潜在推理能力。

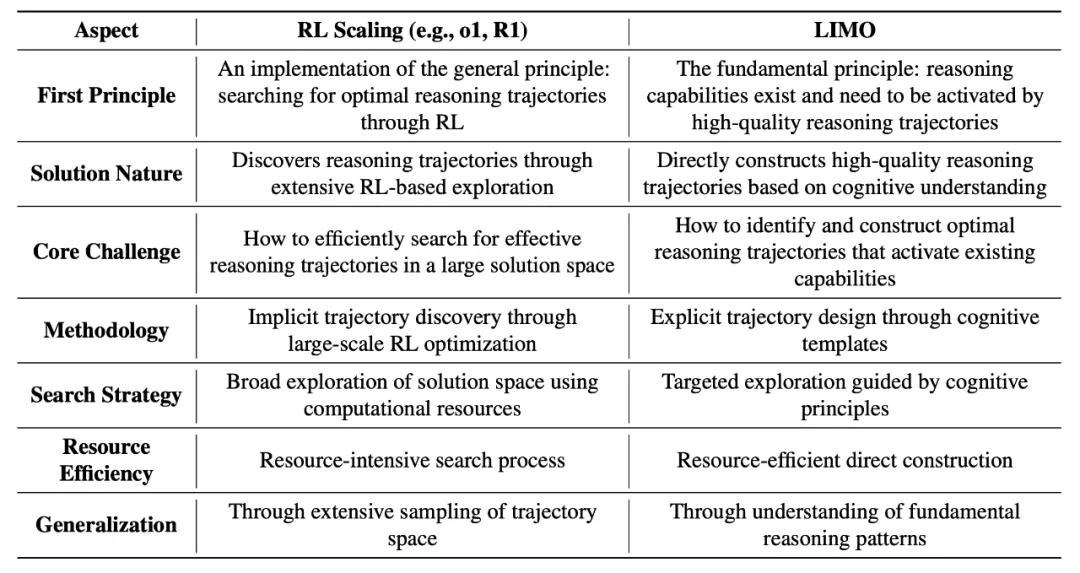

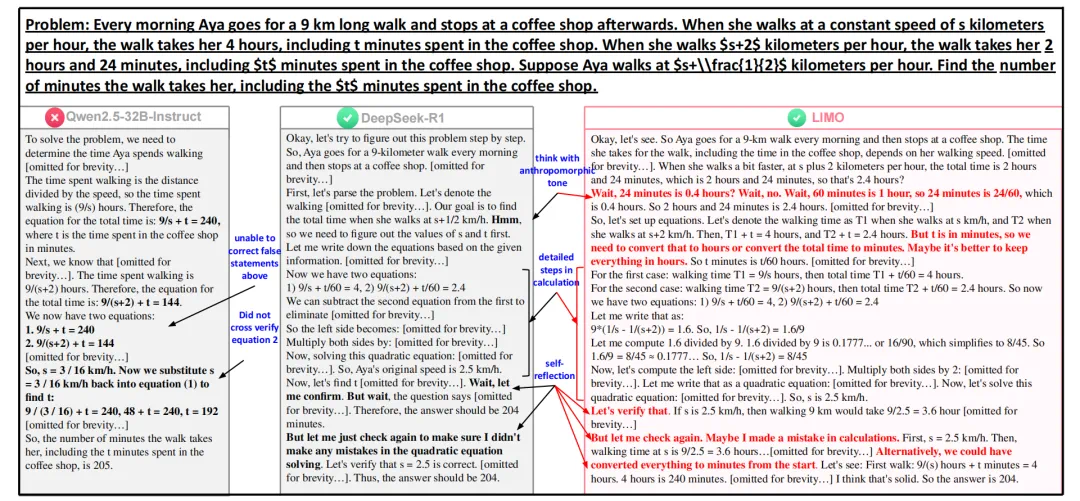

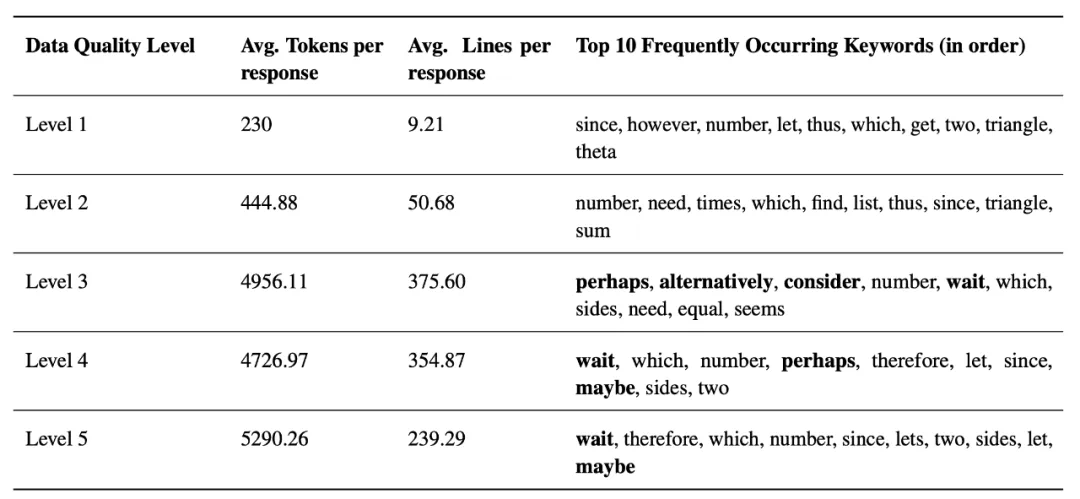

三、LIMO与强化学习扩展的对比

传统强化学习扩展方法(如OpenAI的o1系列和DeepSeek-R1)依赖海量数据和复杂算法,将推理能力提升视为一个“搜索”过程。而LIMO则专注于“激活”模型已具备的能力,强调方向的重要性,将强化学习视为寻找最优推理轨迹的一种手段。

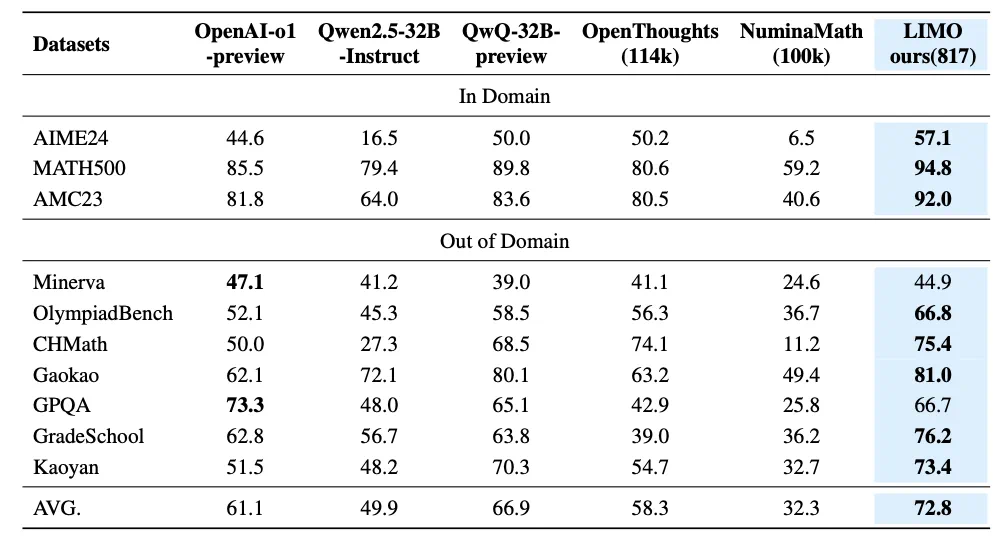

四、实验结果:显著超越传统方法

LIMO在多个基准测试中均取得了显著优于其他模型的结果,例如在AIME24测试中准确率高达57.1%,远超其他模型。这证明了高质量小样本数据的巨大潜力。

五、数据的三重密码:推理链质量、问题难度、预训练知识

LIMO数据集的成功,在于这三个关键因素:高质量推理链、更具挑战性的问题和高质量预训练知识。

六、案例与定量分析:LIMO的卓越表现

具体的案例分析和定量数据进一步证明了LIMO的卓越推理能力和自我反思能力。

七、未来展望:少即是多的无限可能

LIMO的研究为未来研究指明了方向,包括领域泛化、理论基础研究、自动化评估、多模态集成、实际应用和认知科学的结合等。LIMO的成功,标志着人工智能推理能力觉醒的新篇章。

以上就是817样本激发7倍推理性能:上交大「少即是多」定律挑战RLScaling范式的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略