在人工智能与数字交互的前沿领域,清华大学与腾讯强强联手,共同推出了革命性的动作迁移模型——FlexiAct。这一创新技术标志着我们在虚拟世界与现实动作融合上的重大突破。FlexiAct通过高度精密的算法,实现了不同个体间动作的流畅迁移,为远程教育、虚拟现实游戏、以及人机交互等场景开启了全新的可能性。它不仅能够精准捕捉动作细节,还能适应多种身体特征和环境变化,让数字角色的动作更加自然、真实,极大地丰富了用户体验,预示着未来数字内容创作和交互方式的一场变革。这项技术的诞生,是学术界与产业界深度合作的典范,彰显了中国在人工智能技术创新领域的强大实力和前瞻视野。

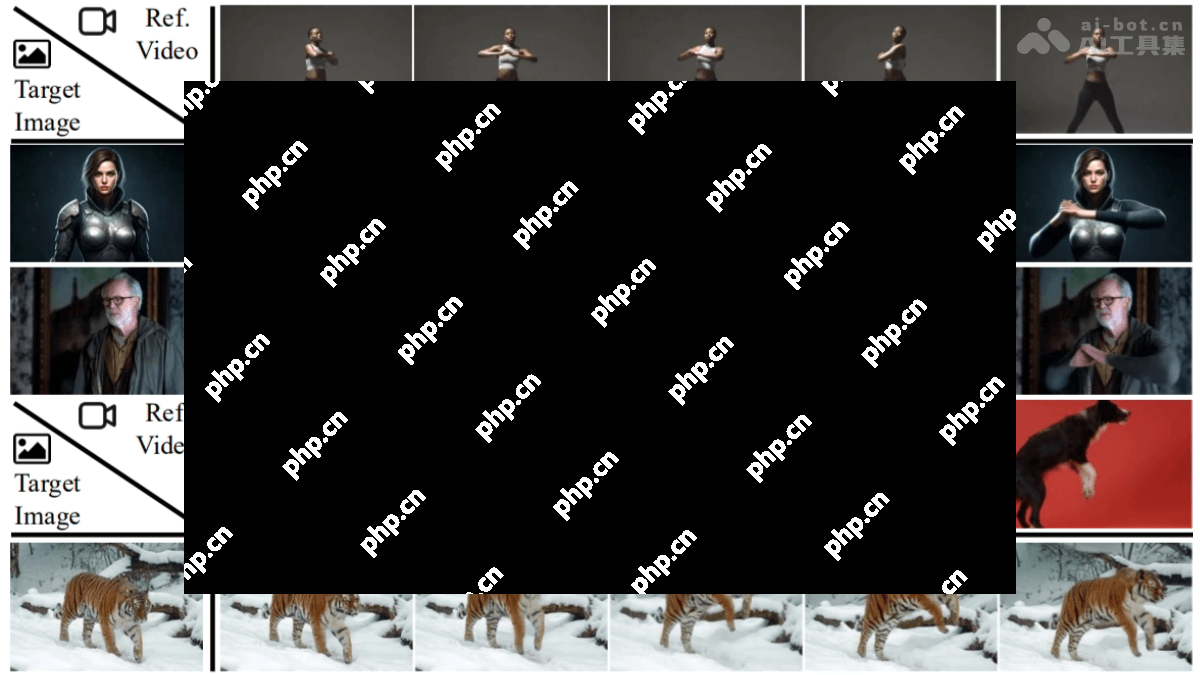

FlexiAct是什么flexiact是由清华大学与腾讯arc实验室共同开发的新型动作迁移模型。该模型能够在提供目标图像的情况下,将参考视频中的动作准确地转移到目标主体上,即使在空间结构差异显著或跨域的异构场景中,也能实现精确的动作匹配和外观一致性。flexiact通过引入轻量级的refadapter模块和频率感知动作提取(fae)模块,克服了现有方法在布局、视角和骨架结构差异方面的局限性,同时保持了身份的一致性。该模型在人物和动物的动作迁移方面表现优异,具有广泛的应用潜力。

FlexiAct的主要功能

跨主体动作迁移:支持将动作从一个人转移到另一个人,或从人转移到动物。

保持外观一致性:在转移动作的同时,确保目标主体的外观(如服装、发型等)与原始目标图像保持一致。

灵活的空间结构适配:即使参考视频和目标图像在布局、视角和骨架结构上存在差异,也能实现动作的自然转移。

FlexiAct的技术原理

RefAdapter(空间结构适配器):RefAdapter是一个轻量级的图像条件适配器,主要用于解决参考视频和目标图像之间的空间结构差异问题。在训练过程中,随机选择视频帧作为条件图像,以最大化空间结构的差异性。这使得模型能够适应不同的姿态、布局和视角,同时保持外观的一致性。通过注入少量可训练参数(如LoRA模块),在CogVideoX-I2V的MMDiT层中实现灵活的空间适配,避免了传统方法中的严格约束。

频率感知动作提取:FAE是一个创新的动作提取模块,直接在去噪过程中完成动作提取,不依赖于独立的时空架构。FAE观察到在去噪的不同时间步中,模型对运动(低频)和外观细节(高频)的关注程度不同。在早期时间步中,模型更关注运动信息;在后期时间步中,模型更关注外观细节。FAE基于动态调整注意力权重,优先在早期时间步提取运动信息,在后期时间步关注外观细节,从而实现精准的动作提取和控制。

FlexiAct的项目地址

项目官网:

GitHub仓库:

HuggingFace模型库:

arXiv技术论文:

FlexiAct的应用场景

影视制作:快速生成逼真的角色动作,降低拍摄成本。

游戏开发:为游戏角色生成多样化的动作,提升游戏体验。

广告营销:生成虚拟代言人的动作,增强广告的吸引力。

教育培训:生成教学和康复训练的动作,辅助学习和恢复。

娱乐互动:支持用户创作有趣的视频,提升娱乐体验。

FlexiAct的主要功能

跨主体动作迁移:支持将动作从一个人转移到另一个人,或从人转移到动物。

保持外观一致性:在转移动作的同时,确保目标主体的外观(如服装、发型等)与原始目标图像保持一致。

灵活的空间结构适配:即使参考视频和目标图像在布局、视角和骨架结构上存在差异,也能实现动作的自然转移。

FlexiAct的技术原理

RefAdapter(空间结构适配器):RefAdapter是一个轻量级的图像条件适配器,主要用于解决参考视频和目标图像之间的空间结构差异问题。在训练过程中,随机选择视频帧作为条件图像,以最大化空间结构的差异性。这使得模型能够适应不同的姿态、布局和视角,同时保持外观的一致性。通过注入少量可训练参数(如LoRA模块),在CogVideoX-I2V的MMDiT层中实现灵活的空间适配,避免了传统方法中的严格约束。

频率感知动作提取:FAE是一个创新的动作提取模块,直接在去噪过程中完成动作提取,不依赖于独立的时空架构。FAE观察到在去噪的不同时间步中,模型对运动(低频)和外观细节(高频)的关注程度不同。在早期时间步中,模型更关注运动信息;在后期时间步中,模型更关注外观细节。FAE基于动态调整注意力权重,优先在早期时间步提取运动信息,在后期时间步关注外观细节,从而实现精准的动作提取和控制。

FlexiAct的项目地址

项目官网:

GitHub仓库:

HuggingFace模型库:

arXiv技术论文:

FlexiAct的应用场景

影视制作:快速生成逼真的角色动作,降低拍摄成本。

游戏开发:为游戏角色生成多样化的动作,提升游戏体验。

广告营销:生成虚拟代言人的动作,增强广告的吸引力。

教育培训:生成教学和康复训练的动作,辅助学习和恢复。

娱乐互动:支持用户创作有趣的视频,提升娱乐体验。

以上就是FlexiAct—清华联合腾讯推出的动作迁移模型的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点