在技术的浩瀚宇宙中,macOS平台迎来了一次激动人心的整合,将前沿的大模型DeepSeek带入了苹果用户的指尖之下。这不仅是一场技术的盛宴,更是开源社区创意火花的碰撞展现。DeepSeek,这个承载着复杂计算与智能推理的重量级模型,与用户友好的Ollama及直观的Open WebUI携手,共同开启了探索知识新纪元的大门。Ollama以其灵活的接口和对大模型的强大支持,成为了连接用户与DeepSeek深邃智慧的桥梁,而Open WebUI则以简洁优雅的界面设计,让这一切高深的交互变得触手可及。在macOS的流畅体验下,无论是科研人员、开发者还是好奇的探索者,都能无缝接入,体验从提问到获得洞见的瞬间转换,共同见证人机合作的新篇章。

2025年1月20日,杭州的一家公司开源推理模型deepseek-r1,一经推出就震撼了世界。

不单单是媲美OpenAIO3的推理能力,更是用极低的成本,惊艳了世界。更何况,DeepSeek-R1是开源的,任何人都可以部署,实现本地运行大模型,真正的OPEN。

比较有趣的是,DeepSeek671B模型,有非常多的“蒸馏版本”,而且“蒸馏版本”对高端显卡的依赖低,性能也基本满足个人使用。

本文将介绍如何在macOS上部署Ollama和OpenWebUI,实现本地运行DeepSeek大模型。

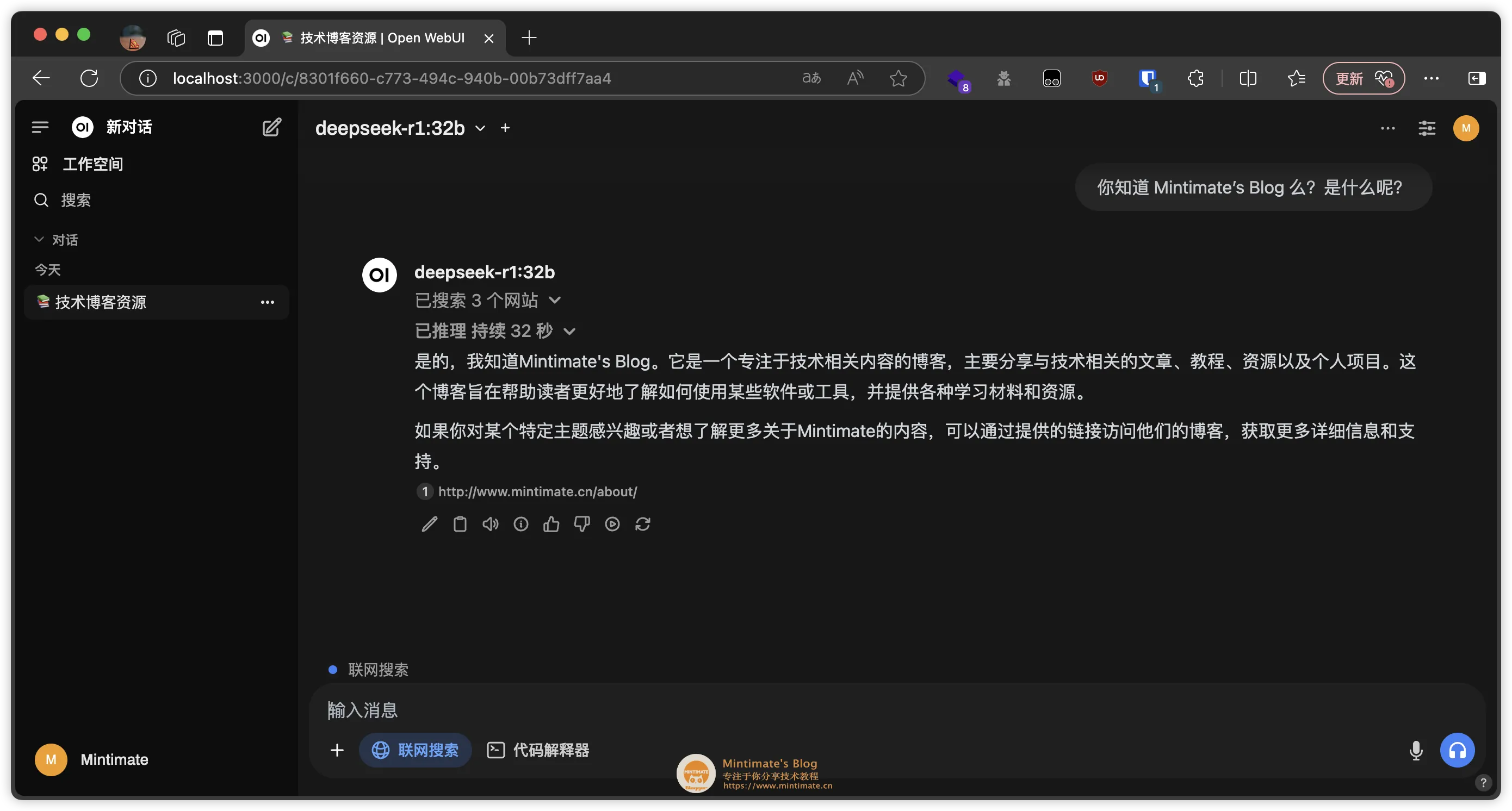

最后的效果:

本地部署32B版本DeepSeek部署思路

本地部署32B版本DeepSeek部署思路

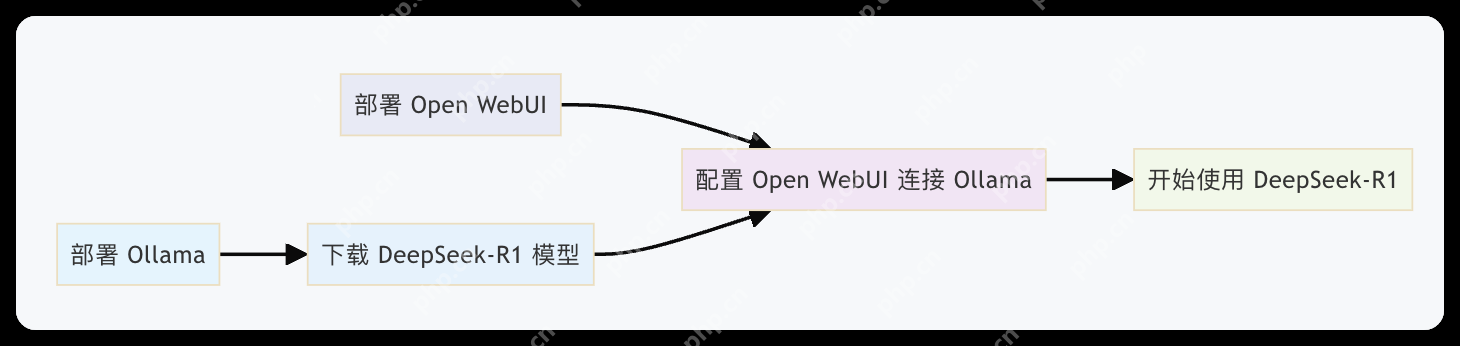

目前本地部署DeepSeek-R1的途径很多,主流的方法是使用Ollama+OpenWebUI或者Ollama+ChatbotUI;我个人是觉得Ollama+OpenWebUI更加实用,所以我们就部署这两个“小家伙”吧:

Ollama:一个轻量级、可扩展的框架,用于在本地计算机上构建和运行语言模型。支持从服务器拉取Llama3.3,DeepSeek-R1,Phi-4和Gemma2等模型。OpenWebUI:一个轻量的开源网页AI接口程序,用于在浏览器中调用本地、远程接口语言模型。支持使用Ollama模型进行对话、文本生成和文本摘要等任务。所以,我们是先本地部署Ollama,之后使用Ollama拉取DeepSeek-R1模型,最后使用OpenWebUI调用Ollama模型,实现本地运行DeepSeek-R1大模型。部署流程如下图所示:

本地流程图

本地流程图

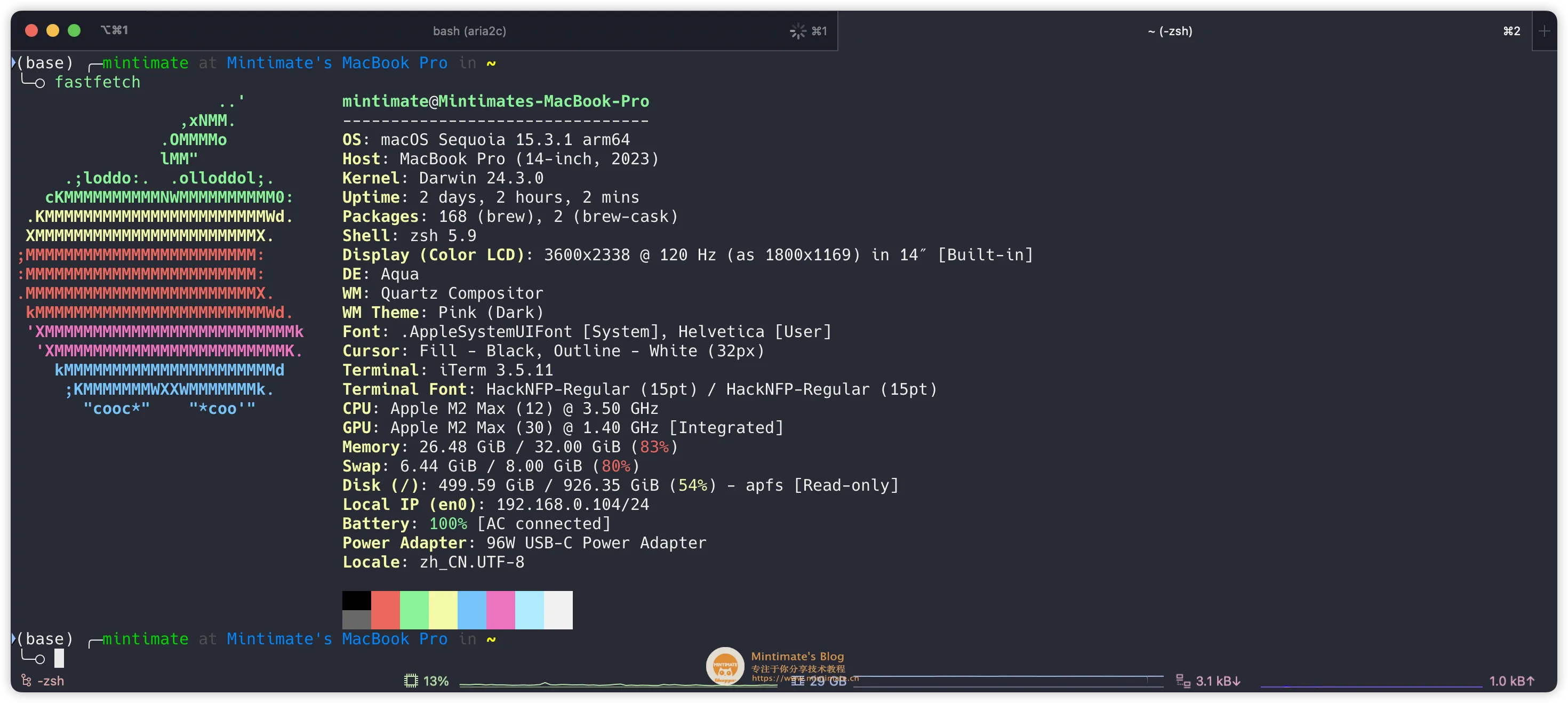

我的电脑配置:

MacBookPro(14-inch,2023)M2Max32GB 我的电脑配置Ollama部署

我的电脑配置Ollama部署

这里有两个方法可以部署Ollama,分别是二进制包安装和Docker安装。

nice~安装Ollama

nice~安装Ollama

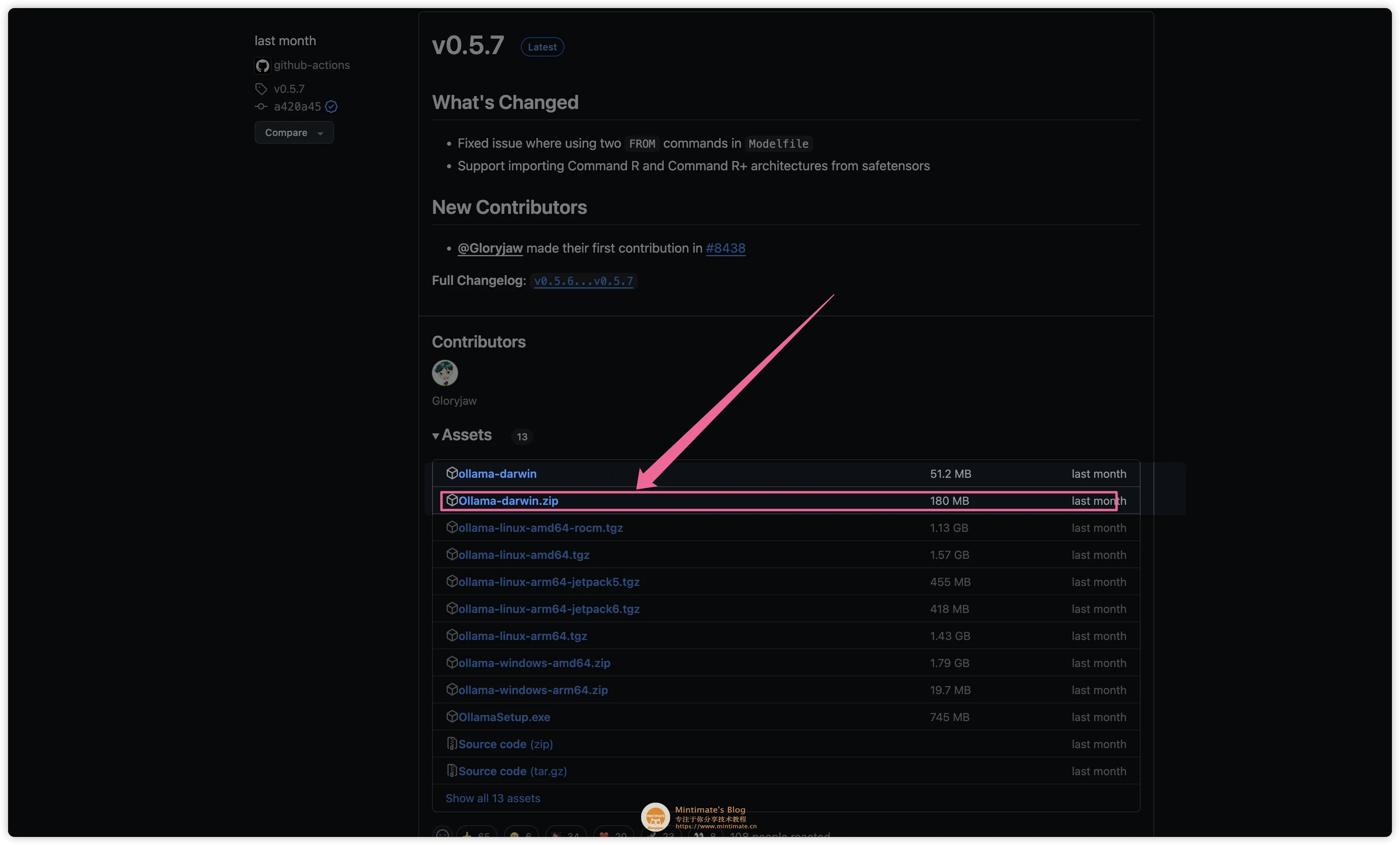

如果你想要更好的性能,那么推荐使用二进制包安装,因为二进制包安装的Ollama性能更好。进入OllamaReleases页面,下载最新版本的Ollama:

下载Ollama

下载Ollama

你也可以通过Ollama官网的链接,自动下载最新版本的Ollama:

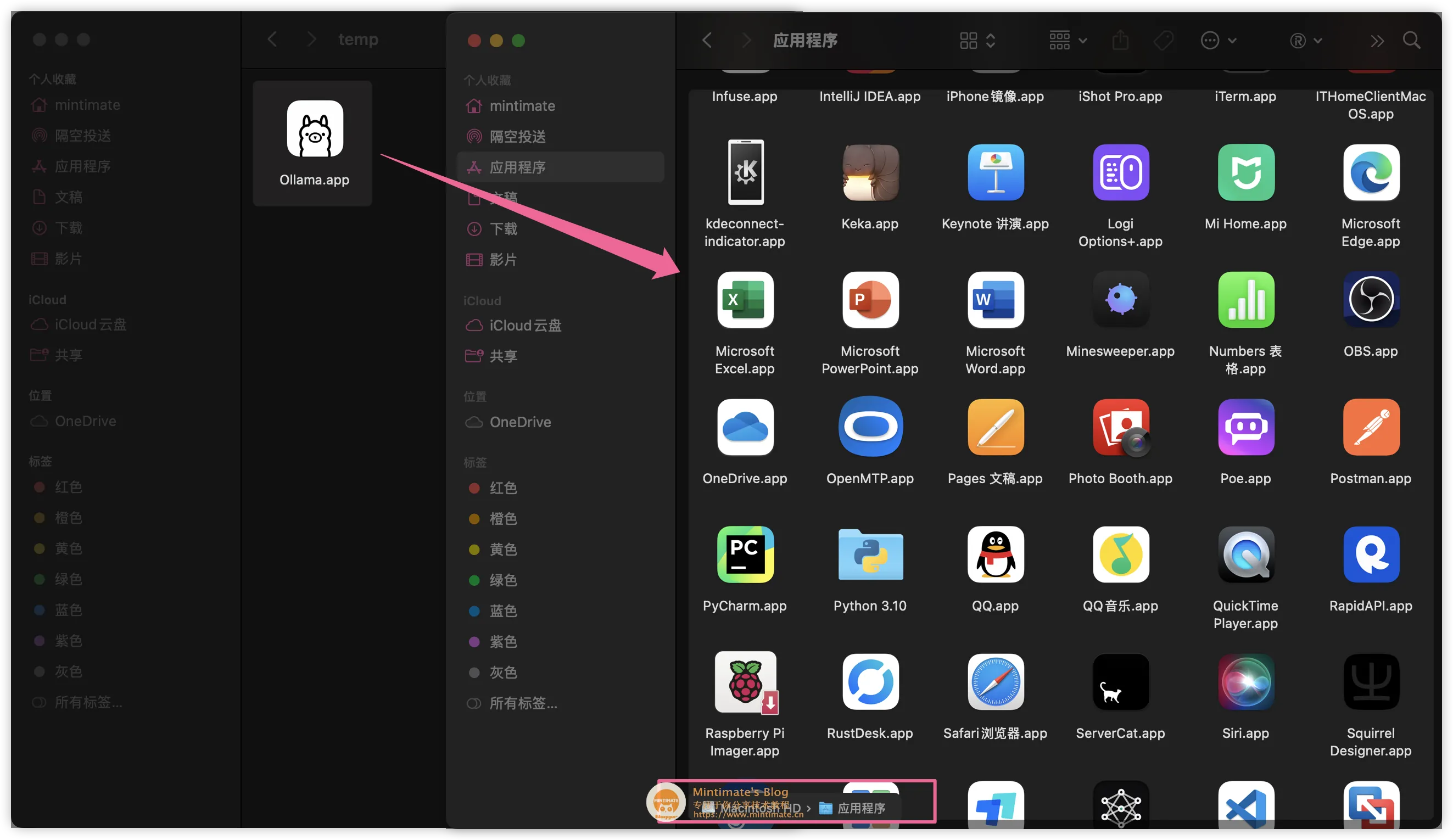

解压下载的Ollama文件,将内部的Ollama文件移动到应用文件夹内:

移动Ollama

移动Ollama

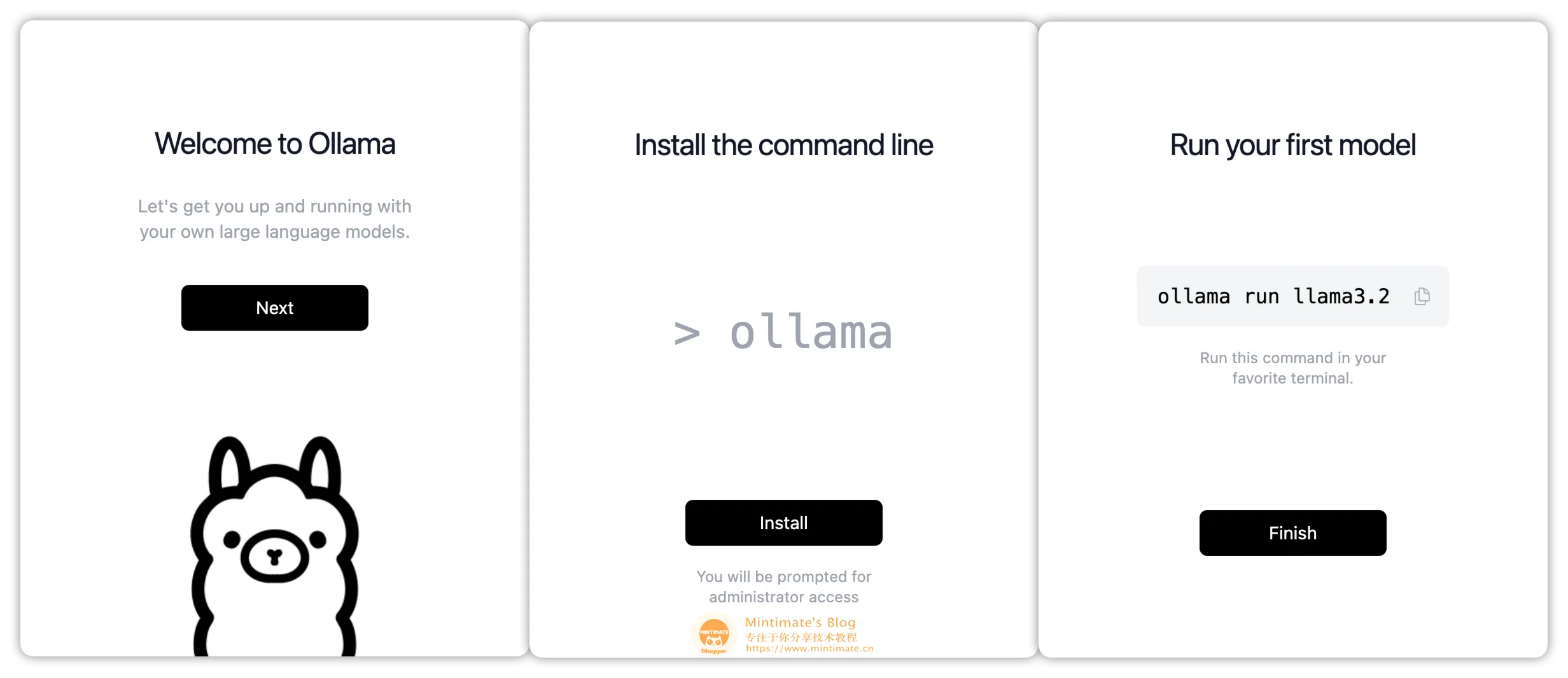

双击打开,点击安装后,即可在终端内调用:

安装Ollama代码语言:bash

复制

#查看Ollama版本ollama--version#Ollama命令帮助ollama-h登录后复制

安装Ollama代码语言:bash

复制

#查看Ollama版本ollama--version#Ollama命令帮助ollama-h登录后复制

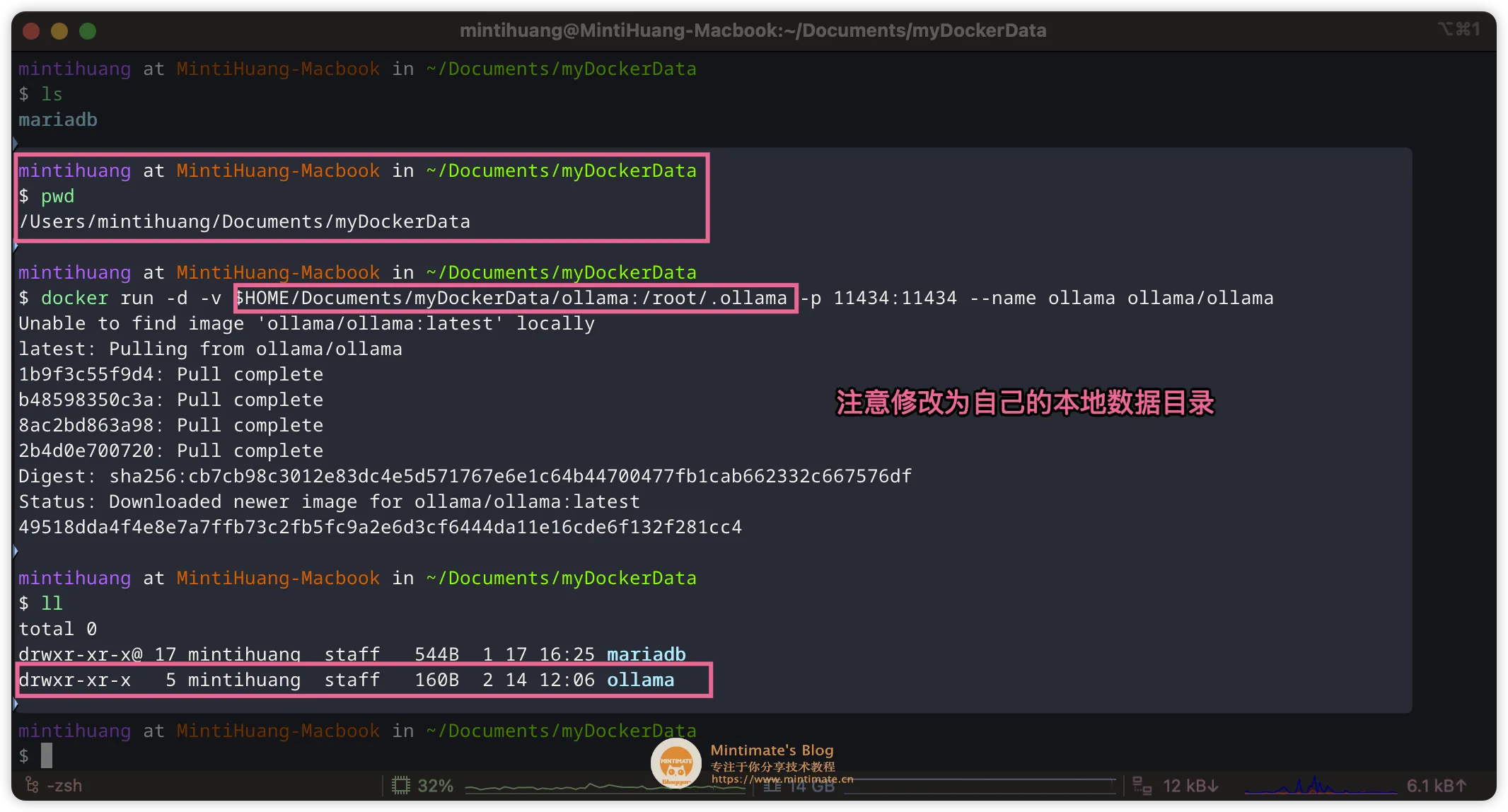

如果你想使用Docker部署Ollama,那么可以参考Ollama官方Docker镜像。直接拉取Ollama的Docker镜像:

代码语言:bash 复制 #拉取镜像并映射端口运行dockerrun-d-v$HOME/Documents/myDockerData/ollama:/root/.ollama-p11434:11434--nameollamaollama/ollama登录后复制 Docker拉取Ollama拉取模型

Docker拉取Ollama拉取模型

我们可以在Ollama的官网查询到模型的ID:

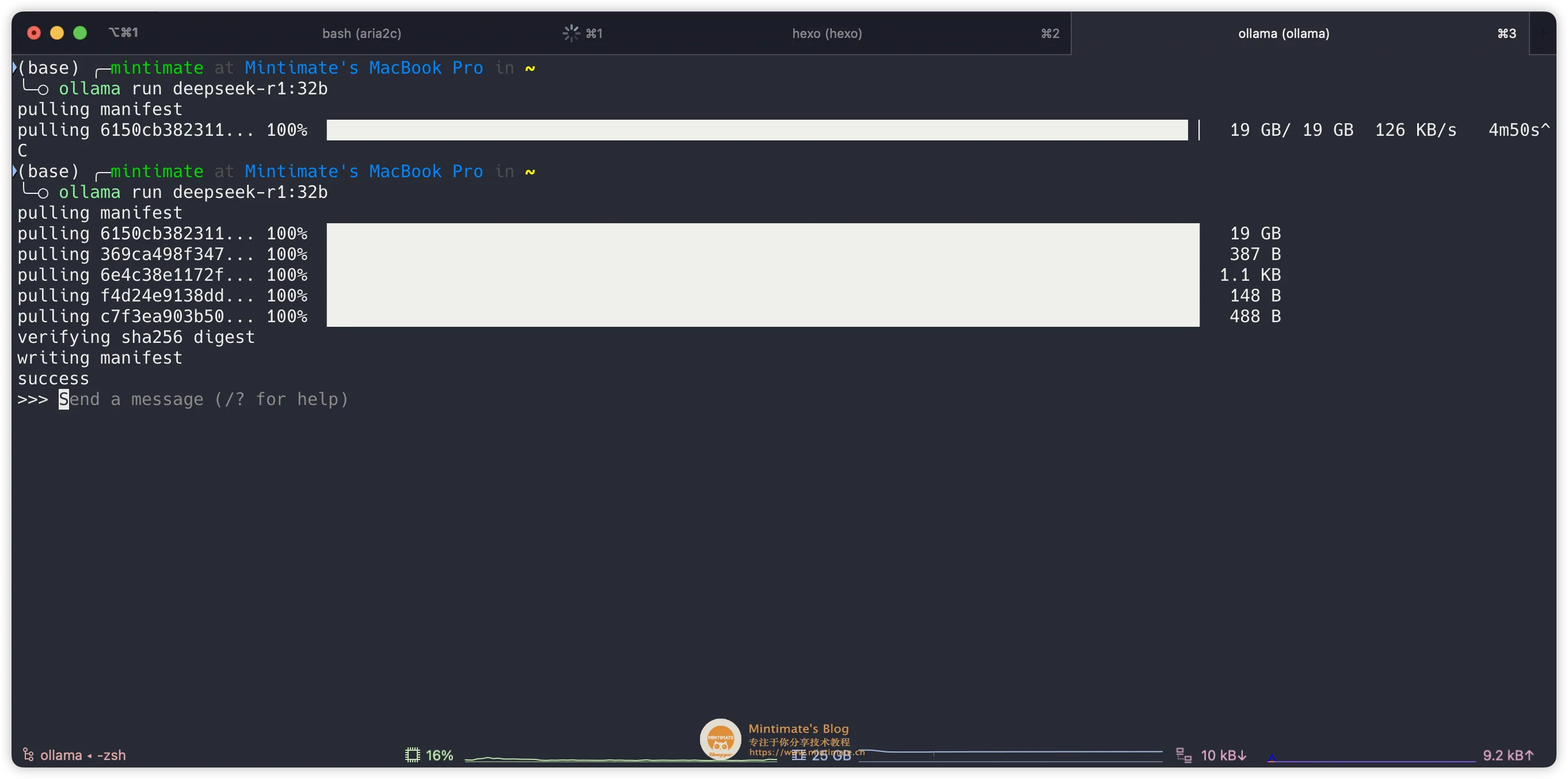

比如我们这次演示使用32B蒸馏版本的,那么ID就是deepseek-r1:32b。同时,Ollama的拉取命令是:

代码语言:bash 复制 #拉取并运行ollamarundeepseek-r1:32b#也可以仅仅拉取ollamapulldeepseek-r1:32b登录后复制复制命令,到终端内执行即可(如果你使用Docker版本的Ollama,那么需要先dockerexec-itollama/bin/bash进入容器内再执行):

拉取DeepSeek-R1模型

拉取DeepSeek-R1模型

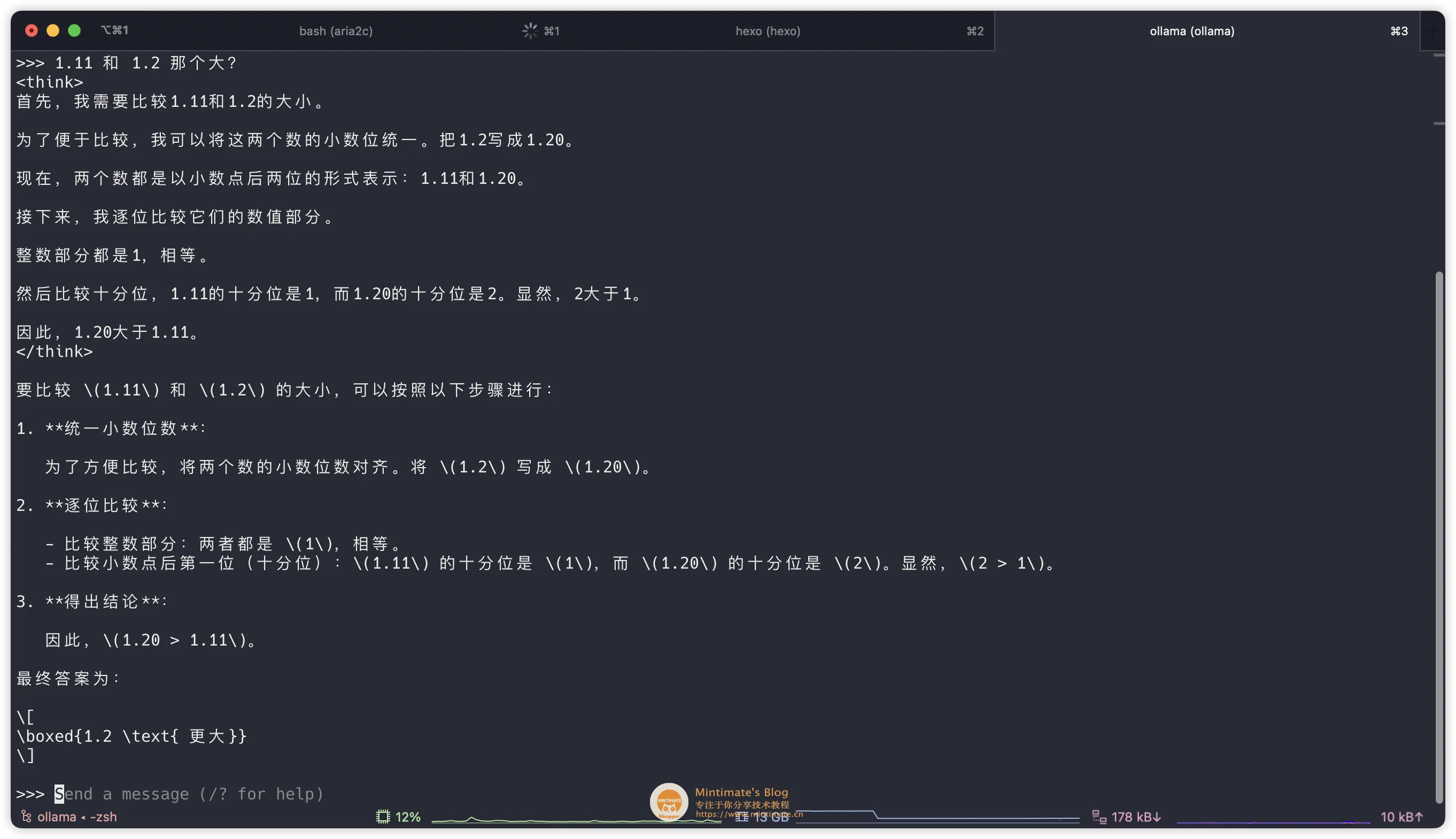

这个时候,相当于我们使用Ollama直接运行模型,你可以直接进行提问,比如:

使用Ollama模型

使用Ollama模型

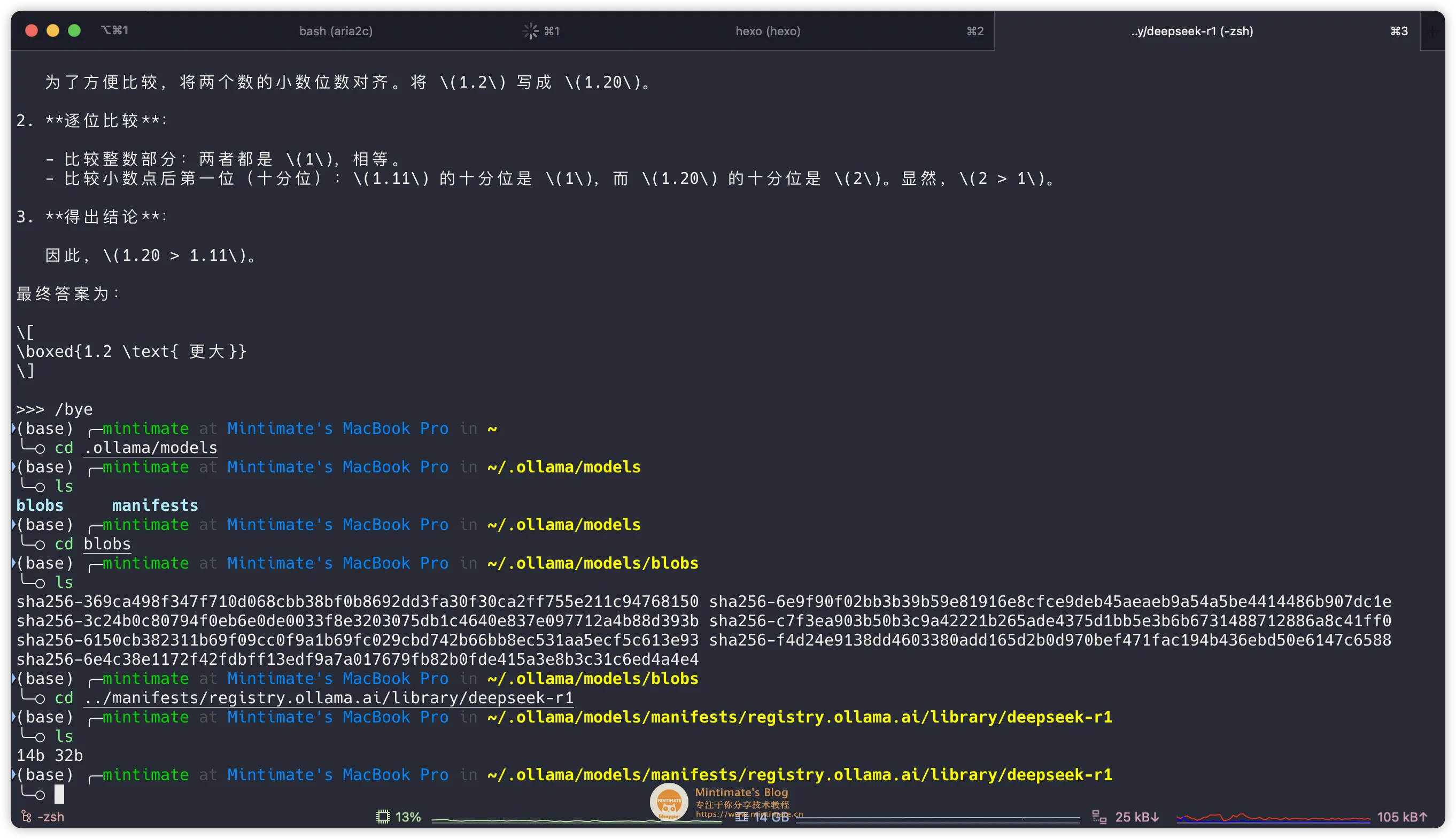

输入/bye,可以退出当前模型交互。后续我们使用OpenWebUI通过Ollama的API进行调用。

模型的本地存放地址,在~/.ollama/models内:

模型本地存放地址

模型本地存放地址

到此,Ollama和模型就部署完成了。

哈哈,真不错~OpenWebUI部署

哈哈,真不错~OpenWebUI部署

同样,有两种方法可以部署OpenWebUI,分别是Docker安装和Pythonpip安装。

如果选择pip安装;只需要在Python版本≥3.8的情况下,一步即达安装:

代码语言:bash 复制 #安装OpenWebUIpipinstallopen-webui#启动OpenWebUIopen-webuiserve登录后复制如果你想使用Docker部署OpenWebUI,那么可以参考OpenWebUI官方文档。直接拉取OpenWebUI的Docker镜像:

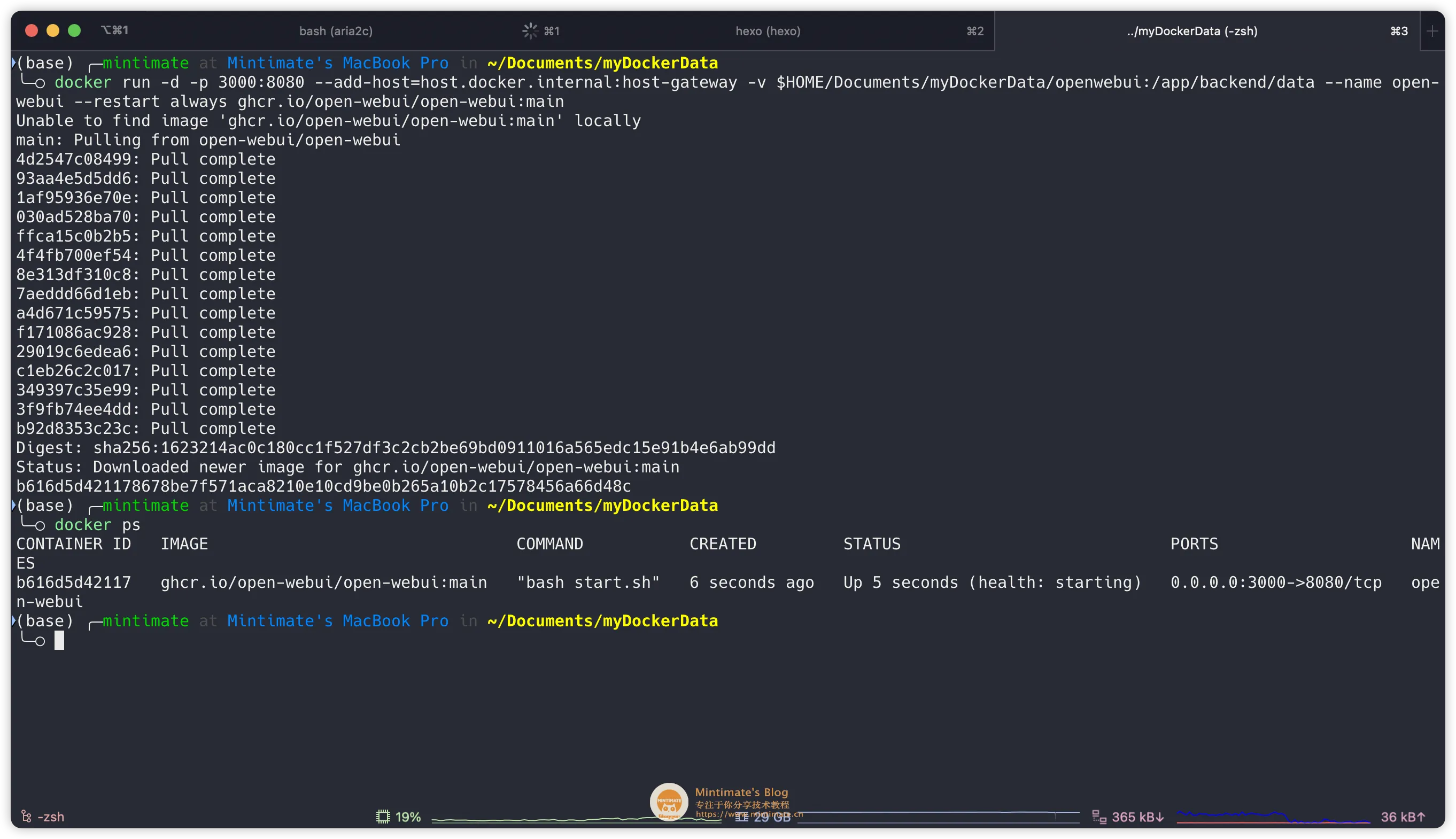

代码语言:bash 复制 #拉取镜像并映射端口运行dockerrun-d-p3000:8080--add-host=host.docker.internal:host-gateway-v$HOME/Documents/myDockerData/openwebui:/app/backend/data--nameopen-webui--restartalwaysghcr.io/open-webui/open-webui:main登录后复制 Docker拉取OpenWebUI

Docker拉取OpenWebUI

解释一下参数:

-p3000:8080:将容器的8080端口映射到主机的3000端口;--add-host=host.docker.internal:host-gateway:将容器内的host.docker.internal解析为宿主机的IP地址(通过host-gateway动态获取)。浏览器访问即可进入OpenWebUI的界面。根据提示初始化账号即可:

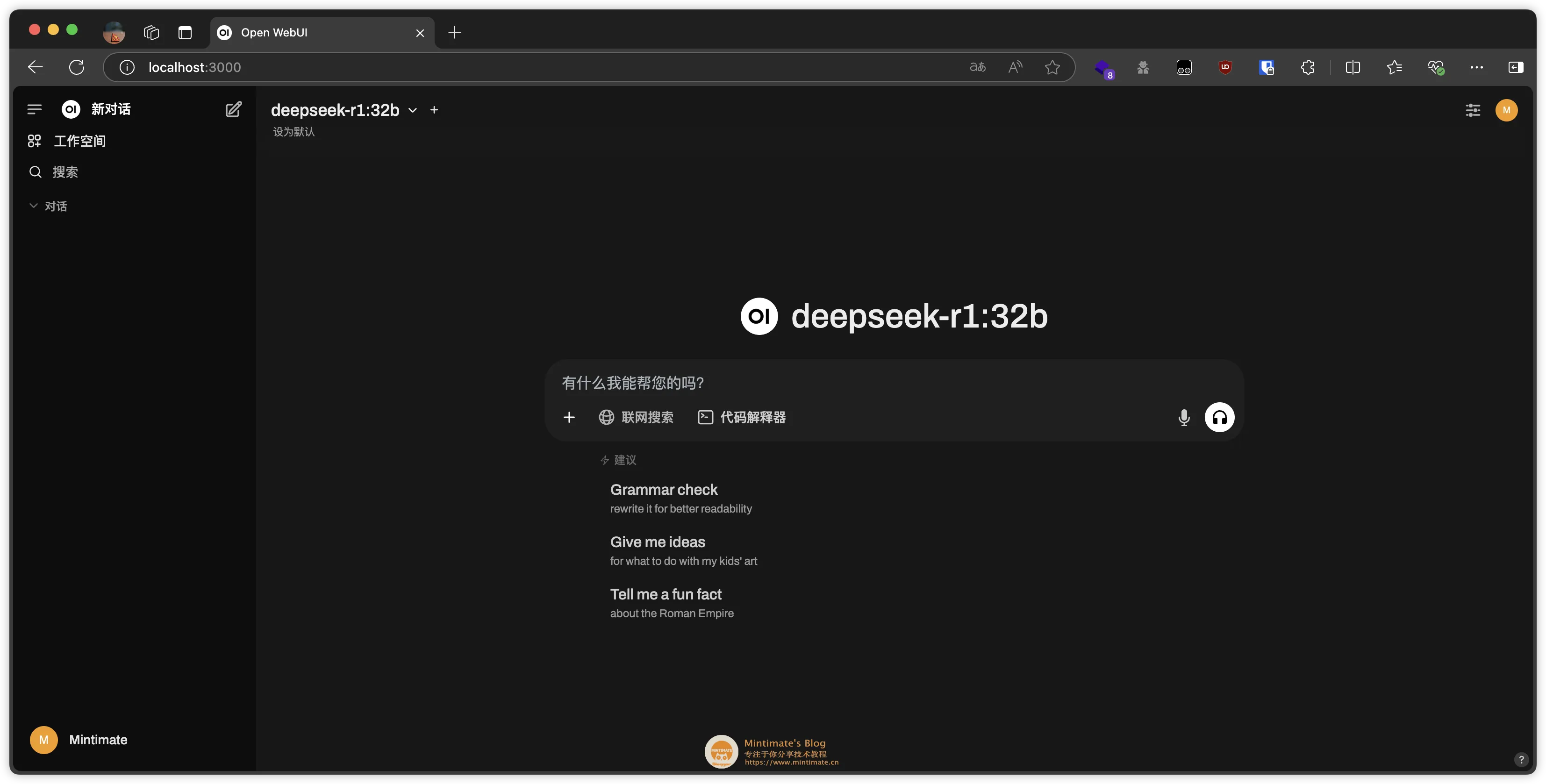

OpenWebUI界面配置OpenWebUI

OpenWebUI界面配置OpenWebUI

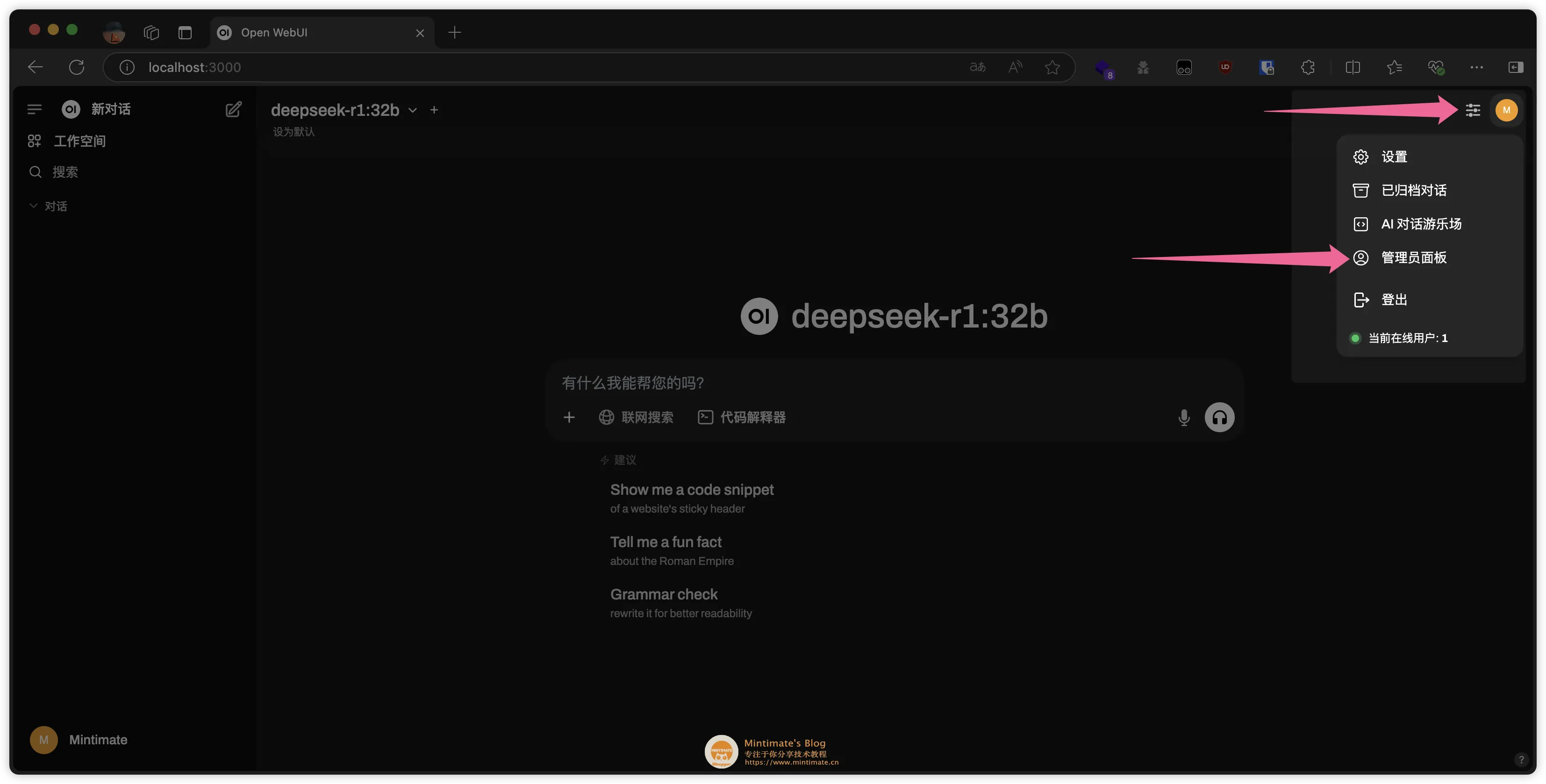

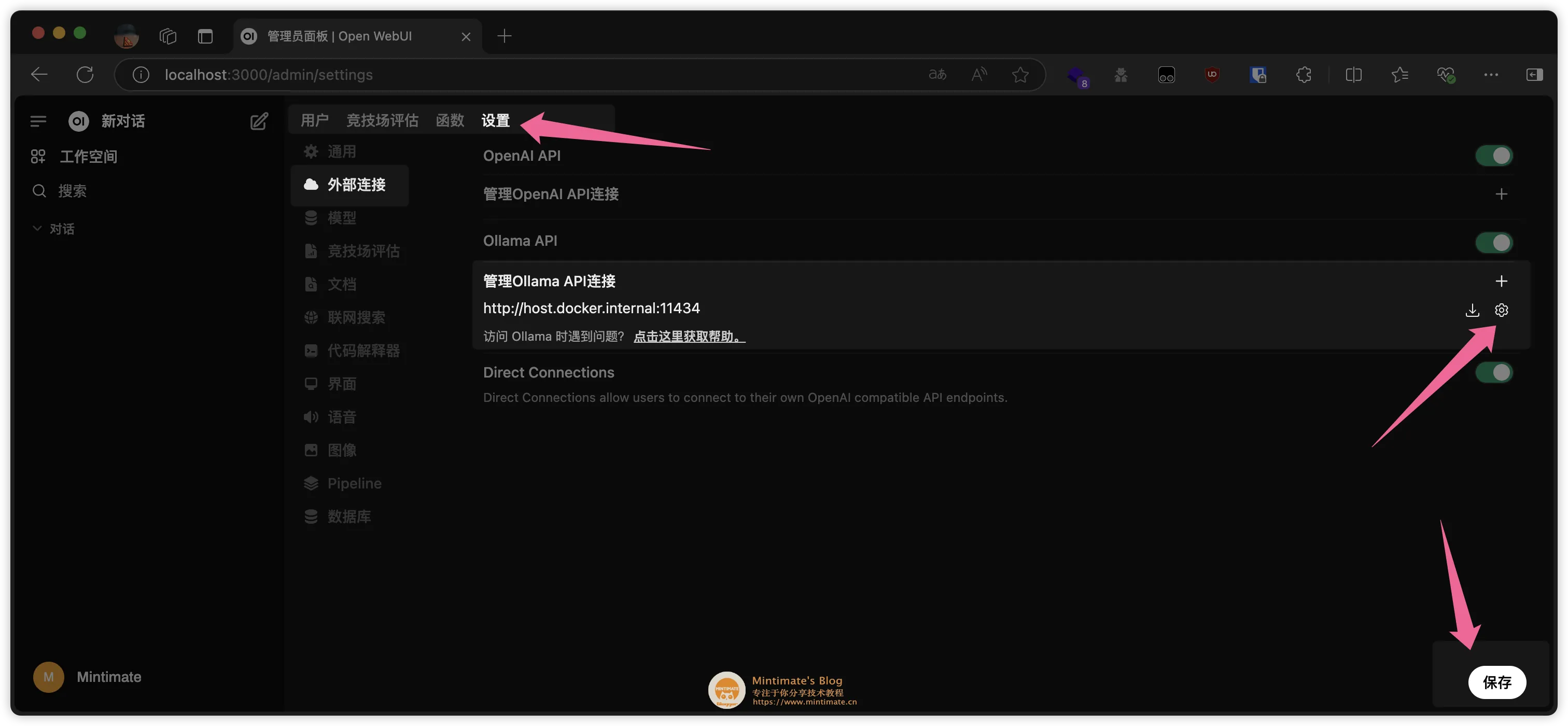

其实本地OpenWebUI和Ollama的配置,已经做到了开箱即用。存在部分情况需要设置API接口,或者设置远程ollama的接口用于本地调用。

API接口设置默认情况,OpenWebUI会使用Ollama的默认地址进行查询。没有显示模型,你可以在Settings中进行配置:

OpenWebUI配置

OpenWebUI配置 OpenWebUI配置详情配置联网查询

OpenWebUI配置详情配置联网查询

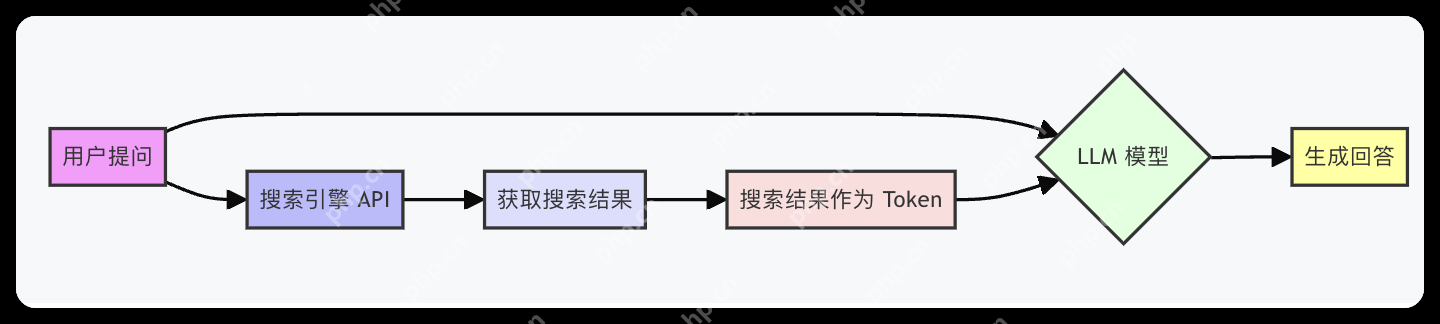

联网查询我这里也提一下。一些小白用户,以为联网查询功能,是DeepSeek模型提供的;实际上,不管是DeepSeek官网,还是OpenWebUI,都是搜索API查询了网上结果后,作为Token内容喂给模型,之后输出结果。

相当于我们自己网上搜索了一下,把搜索结果作为附件,和提问内容一起给模型,模型输出结果。流程图:

联网查询

联网查询

OpenWebUI的联网查询,就是使用搜索引擎API,获取搜索结果。比如,我设置duckduckgo作为搜索引擎:

配置duckduckgo

配置duckduckgo

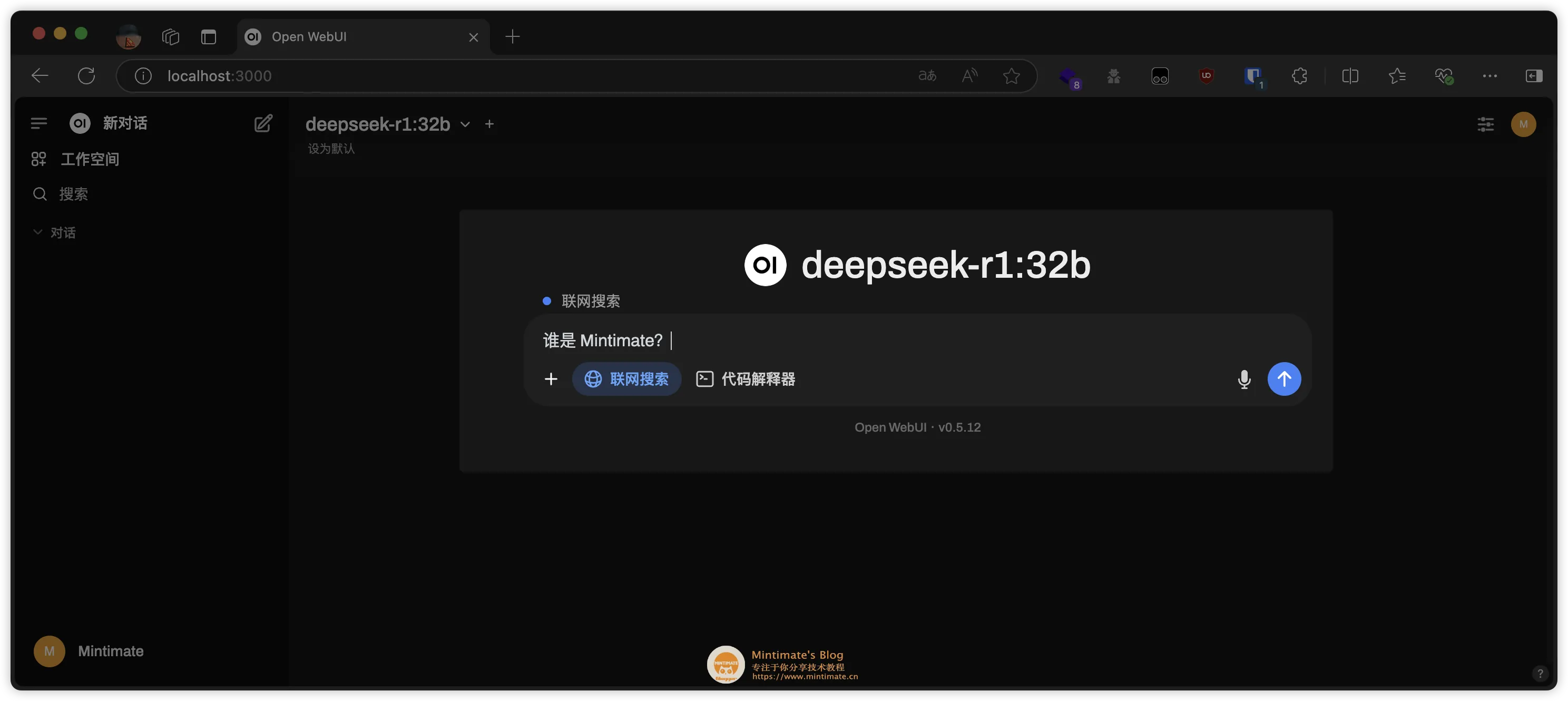

之后,在提问中,即可使用联网搜索功能:

使用duckduckgo搜索

使用duckduckgo搜索

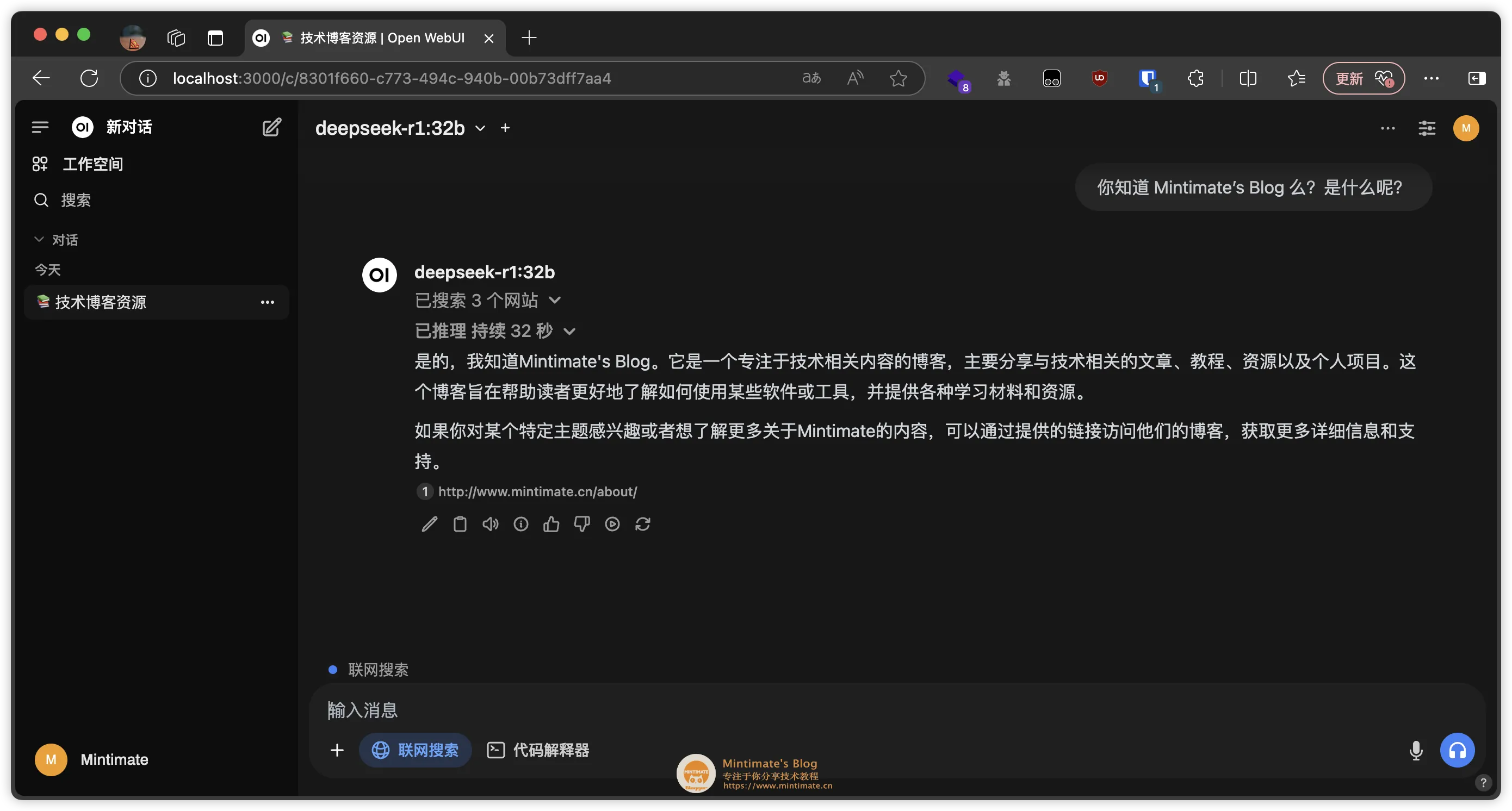

最后的效果:

使用duckduckgo搜索结果Q&A

使用duckduckgo搜索结果Q&A

这里,我收集了一些常见的问题,以及解决方案。

常见疑难问题?如何卸载Ollama

常见疑难问题?如何卸载Ollama

参考GitHubissue:Howtoremoveollamafrommacos?

注意:移除Ollama的配置文件和安装包,只是移除Ollama的本地数据,不会影响Ollama的模型。

如果你是docker部署的,那么移除容器就可以了:

代码语言:bash 复制 dockerstopollamadockerrmollama登录后复制如果你是直接安装的,那么需要先移除Ollama的配置文件,再移除Ollama的安装包:

代码语言:bash 复制 #移除二进制文件rm/usr/local/bin/ollama#删除软件rm-rf~/Library/Application\Support/Ollama登录后复制最后,移除Ollama的登录项即可。

END感谢阅读,如果觉得不错,欢迎点赞、评论、转发。如果有什么问题,欢迎在评论区留言。有机会,我们一起看看本地知识库如何构建~~

以上就是macOS运行DeepSeek大模型!看看Ollama和OpenWebUI如何配合的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略