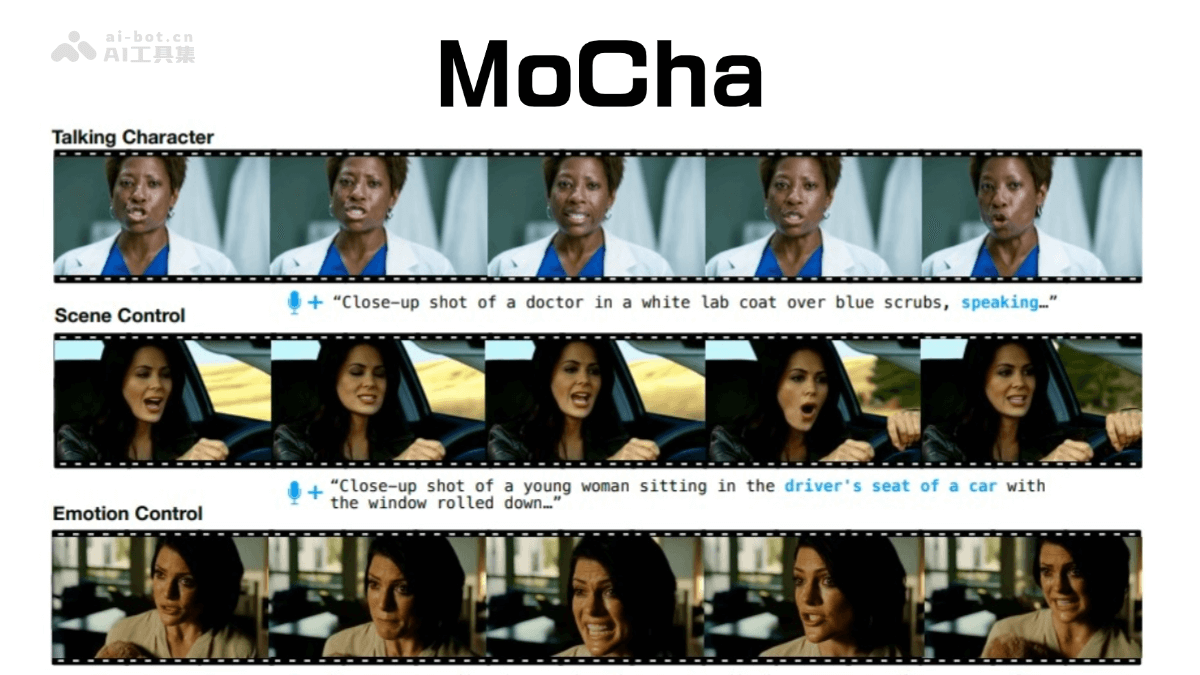

在人工智能的广阔天地里,Meta与滑铁卢大学共同点亮了一颗璀璨的新星——MoCha,这一革命性的技术突破了传统界限,引领我们迈入对话角色视频生成的新纪元。MoCha,一个前所未有的端到端模型,它不仅仅是技术名词的堆砌,而是将创意与科技完美融合的杰作。它能够根据对话内容,自动生成极具生动性的角色视频,为虚拟交互带来无限可能。这不仅仅意味着娱乐和媒体行业的游戏规则将被改写,更预示着教育、远程交流乃至个人化内容创作领域将迎来翻天覆地的变化。通过高度逼真的视觉效果与流畅的对话匹配,MoCha开启了人机交互的新篇章,让数字世界中的沟通更加富有情感与真实感。这不仅是技术的进步,更是人类创造力的一次飞跃,让我们得以探索更加丰富多彩的虚拟现实世界。

meta与滑铁卢大学联袂打造的mochaai,是一款先进的端到端对话式角色视频生成模型。它能够根据文本或语音指令,生成包含同步语音和自然动作的完整角色动画。mochaai的核心突破在于其语音-视频窗口注意力机制,有效解决了视频压缩导致的音频分辨率不匹配和唇部动作错位等难题。该模型支持多角色互动对话,并能生成富有情感表达和全身动作的角色动画。

MoChaAI的主要功能:

语音/文本驱动动画生成:MoChaAI支持语音和文本两种输入模式。语音输入直接驱动角色动画,实现精准的唇形同步和自然动作;文本输入则由模型自动合成语音后再驱动动画。

全身自然动画:MoChaAI不仅生成面部表情和嘴型,还能够生成全身自然流畅的动作,包括手势和角色间的互动,显著提升了动画的真实感。

多角色流畅对话:借助结构化提示模板和角色标签,MoChaAI能轻松处理多角色对话场景,实现角色间的自然互动。只需一次定义角色信息,即可在不同场景中重复使用,简化了操作流程。

MoChaAI的技术原理:

扩散变压器(DiT)架构:MoChaAI采用扩散变压器架构,通过交叉注意力机制融合文本和语音信息,精准捕捉语义和时间动态,从而生成逼真且富有表现力的动画。

语音-视频窗口注意力机制:该机制巧妙地解决了视频压缩和并行生成带来的语音视频对齐问题,确保了角色口型与语音内容的精准匹配。

联合训练策略:MoChaAI采用联合训练策略,利用语音和文本标注的视频数据进行训练,增强了模型在各种角色动作上的泛化能力,并支持对角色表情、动作、互动和环境的精细控制。

结构化提示模板:为简化多角色对话的文本描述,MoChaAI设计了结构化提示模板,通过角色标签来描述角色行为,减少了冗余信息,提升了生成效率。

多阶段训练框架:MoChaAI采用多阶段训练框架,根据镜头类型分阶段训练,逐步提升模型处理复杂任务的能力,并提高训练效率。

MoChaAI的项目信息:

项目官网:

arXiv技术论文:

MoChaAI的应用前景:

虚拟主播:创建更生动自然的虚拟主播,轻松生成vlog、问答等内容。

动画影视创作:降低动画制作成本,生成更自然流畅的角色动画,提升作品质量。

教育内容创作:打造更具吸引力的AI教学内容,提升学习体验。

数字人客服:提供更人性化的数字人客服服务,提升用户满意度。

MoChaAI的主要功能:

语音/文本驱动动画生成:MoChaAI支持语音和文本两种输入模式。语音输入直接驱动角色动画,实现精准的唇形同步和自然动作;文本输入则由模型自动合成语音后再驱动动画。

全身自然动画:MoChaAI不仅生成面部表情和嘴型,还能够生成全身自然流畅的动作,包括手势和角色间的互动,显著提升了动画的真实感。

多角色流畅对话:借助结构化提示模板和角色标签,MoChaAI能轻松处理多角色对话场景,实现角色间的自然互动。只需一次定义角色信息,即可在不同场景中重复使用,简化了操作流程。

MoChaAI的技术原理:

扩散变压器(DiT)架构:MoChaAI采用扩散变压器架构,通过交叉注意力机制融合文本和语音信息,精准捕捉语义和时间动态,从而生成逼真且富有表现力的动画。

语音-视频窗口注意力机制:该机制巧妙地解决了视频压缩和并行生成带来的语音视频对齐问题,确保了角色口型与语音内容的精准匹配。

联合训练策略:MoChaAI采用联合训练策略,利用语音和文本标注的视频数据进行训练,增强了模型在各种角色动作上的泛化能力,并支持对角色表情、动作、互动和环境的精细控制。

结构化提示模板:为简化多角色对话的文本描述,MoChaAI设计了结构化提示模板,通过角色标签来描述角色行为,减少了冗余信息,提升了生成效率。

多阶段训练框架:MoChaAI采用多阶段训练框架,根据镜头类型分阶段训练,逐步提升模型处理复杂任务的能力,并提高训练效率。

MoChaAI的项目信息:

项目官网:

arXiv技术论文:

MoChaAI的应用前景:

虚拟主播:创建更生动自然的虚拟主播,轻松生成vlog、问答等内容。

动画影视创作:降低动画制作成本,生成更自然流畅的角色动画,提升作品质量。

教育内容创作:打造更具吸引力的AI教学内容,提升学习体验。

数字人客服:提供更人性化的数字人客服服务,提升用户满意度。

以上就是MoCha—Meta联合滑铁卢大学推出的端到端对话角色视频生成模型的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略