在人工智能与计算机视觉的前沿领域,英伟达不断突破创新边界,近期推出了革命性的视觉信息处理技术——QLIP(Quality-Aware Lightweight Image Processing)。这一创新方法不仅标志着图像处理技术的重大进步,更是在追求高效与质量并举的道路上树立了新的里程碑。QLIP旨在通过一种更为智能和轻量级的方式,对图像进行标记化处理,从而极大地优化视觉数据的传输、存储与分析过程。它利用深度学习算法的精妙,实现了对图像内容的高度提炼,不仅保持了视觉信息的高质量,同时显著降低了数据处理的复杂度和资源消耗。这不仅为自动驾驶、远程医疗、增强现实等依赖高精度视觉处理的行业带来了福音,也预示着未来视觉技术应用将更加广泛且高效。

qlip(quantizedlanguage-imagepretraining)是英伟达等公司推出的一种视觉标记化技术,旨在结合高质量的图像重建和零样本图像理解能力。qlip通过二进制球形量化(bsq)的自编码器进行训练,同时优化重建目标和语言-图像对齐目标。qlip能够作为视觉编码器或图像标记器,无缝集成到多模态模型中,在理解与生成任务中表现出色,为统一多模态模型的开发提供了新的思路。

QLIP的主要功能包括:

高质量图像重建:以较低的压缩率重建高质量的图像。 强大的语义理解:支持生成语义丰富的视觉标记,支持零样本图像分类和多模态理解任务。 多模态任务支持:作为视觉编码器或图像标记器,无缝集成到多模态模型中,支持文本到图像生成、图像到文本生成等任务。 统一的多模态模型:支持一个模型同时处理纯文本、图像到文本和文本到图像的任务。QLIP的技术原理包括:

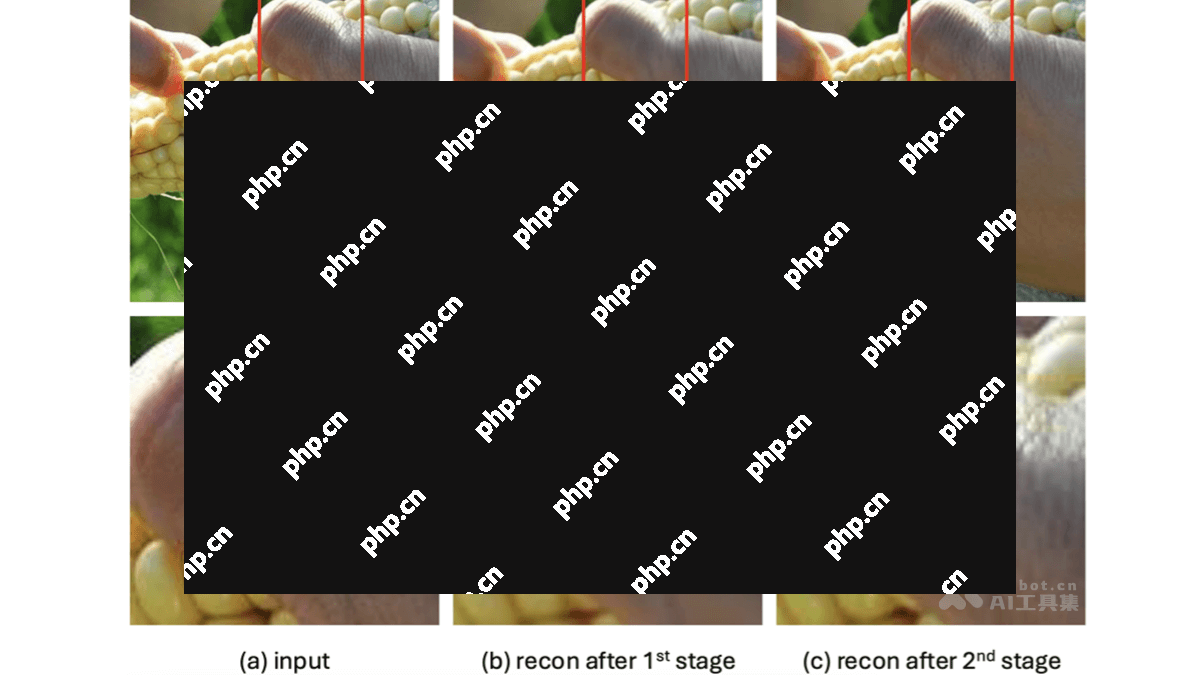

二进制球形量化(BSQ):使用二进制球形量化技术,将图像编码为离散的视觉标记。BSQ将高维空间中的点映射到单位球面上的二进制角点,实现高效的量化和压缩。 对比学习目标:QLIP引入对比学习目标,通过图像文本对齐的方式,使视觉标记与语言嵌入对齐。QLIP使用InfoNCE损失函数,学习将同一图像和文本对的嵌入拉近,将不同对的嵌入推远。对齐机制使视觉标记能够重建图像并理解图像的语义内容。 两阶段训练: 第一阶段:优化重建损失、量化损失和对比损失的加权和,目标是学习语义丰富的视觉表示,同时保持图像的重建质量。 第二阶段:在第一阶段的基础上,进一步优化重建质量,通过微调量化瓶颈和视觉解码器,恢复高频细节。这一阶段会丢弃文本编码器并冻结视觉编码器,避免在大批次训练时的性能退化。 动态平衡损失:基于动态调整对比损失和重建损失的权重,解决两种目标之间的竞争问题。具体方法是根据损失值的倒数调整权重,平衡两种目标的收敛速度。 加速训练与更好的初始化:从预训练的模型(如MaskedImageModeling或CLIP)初始化视觉编码器和文本编码器,显著提高训练效率,减少训练所需的样本数量。QLIP的项目地址包括:

项目官网: GitHub仓库: HuggingFace模型库: arXiv技术论文:QLIP的应用场景包括:

多模态理解:用于视觉问答(VQA)和图文推理(GQA),帮助模型理解图像生成准确回答。 文本到图像生成:根据文本描述生成高质量图像,细节更符合语义。 图像到文本生成:生成图像描述(caption),提供更准确的文本内容。 统一多模态模型:支持一个模型同时处理文本、图像到文本和文本到图像的任务。以上就是QLIP—英伟达推出的视觉标记化方法的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略