在人工智能的浩瀚星海中,大型语言模型(LLMs)如同智慧的灯塔,以其深度学习的能力照亮知识的暗角。然而,这些模型的推理过程往往深藏不露,如同迷雾中的航路。为此,我们自豪地介绍ReasonViz——一个创新的开源平台,它致力于揭开LLMs复杂推理的神秘面纱。ReasonViz不仅是一个工具,它是连接人类理解与机器智能的桥梁,让可视化分析成为可能。通过直观的界面和深入的数据洞察,开发者、研究人员乃至普通用户都能探索语言模型决策背后的逻辑链路,从而增强透明度,提升信任度。在ReasonViz的世界里,每一步推理都变得可追溯,每一次思考的跳跃都有迹可循,为我们共同推进AI的边界提供了前所未有的视角。

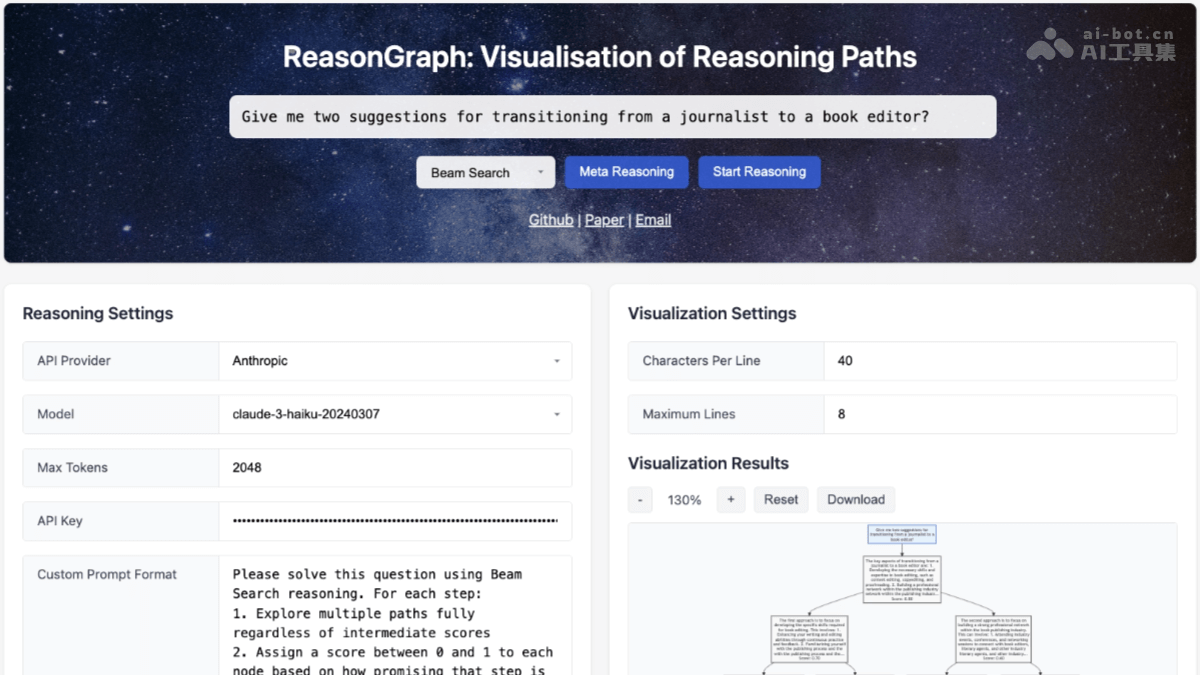

reasongraph:可视化与分析大语言模型推理的开源平台

ReasonGraph是一个开源的网络平台,用于可视化和分析大语言模型(LLMs)的推理过程。它支持50多种主流LLM(例如Anthropic、OpenAI和Google),并兼容多种推理方法,包括顺序推理和树形推理。通过直观的界面,ReasonGraph将复杂的推理路径转换为清晰易懂的图表,实时展现推理过程,方便用户理解AI的思考方式,识别错误并优化模型性能。其模块化设计便于集成新的方法和模型,广泛应用于学术研究、教育和开发领域。

核心功能:

直观可视化:将LLM的推理过程以图表形式呈现,支持树形和顺序推理。 多模型兼容:支持50多种主流LLM,例如OpenAI、Google和Anthropic等。 多种推理方法:涵盖顺序推理和基于树的推理等主流方法。 交互式体验:实时更新推理路径图,支持参数调整、缩放、重置和SVG格式导出。 用户友好界面:简洁易用的UI设计,方便用户选择推理方法、配置模型和查看结果。技术架构:

ReasonGraph采用模块化设计,后端基于Flask框架构建,包含三个核心模块:配置管理器(状态更新和配置管理)、API工厂(提供统一的API接口,支持多种LLM提供商)和推理方法模块(封装不同的推理方法,提供标准化的解析和可视化接口)。前端使用Mermaid.js实现动态图形渲染,并通过RESTfulAPI与后端进行通信。异步事件处理模块确保用户操作(例如选择推理方法和配置参数)能够实时反馈到可视化界面。推理路径解析基于规则化的XML解析方法,准确率接近100%。

项目信息:

GitHub仓库: arXiv论文: 在线演示:应用场景:

学术研究:分析和比较不同推理方法的效率,评估模型在复杂任务中的表现。 教育教学:帮助学生直观理解逻辑推理过程,提升对AI推理原理的学习效率。 模型调试:快速发现推理路径中的错误或低效环节,优化LLM的推理效果。 应用开发:选择最优推理方法,优化应用逻辑,提升用户体验。 推理方法研究:为研究新的推理方法提供可视化支持。以上就是ReasonGraph—开源可视化与分析LLMs推理过程的AI工具的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点