在人工智能领域,每一次技术的跃进都如同星辰大海中的一道闪光,指引着我们向更深邃的未知进发。DeepSeek的最新成果——R1-Zero,正是一次这样的闪耀瞬间,它不仅标志着公司在自学习算法上的重大突破,更是将我们对AI自我进化能力的理解推向了新的高度。相较于其前身R1,R1-Zero之所以更值得关注,是因为它实现了从依赖大量预训练数据到近乎零样本学习的飞跃。这一转变不仅仅是技术参数的优化,而是AI研究范式的一次深刻变革。R1-Zero通过其独特的算法架构,能够在极有限的数据量下快速适应新任务,展现出惊人的泛化能力和自我学习效率,为未来AI在实际应用中的灵活性和广泛性奠定了坚实的基础。这一成就不仅对于学术界意义非凡,更为各行各业如何高效利用AI提供了全新的思考角度。

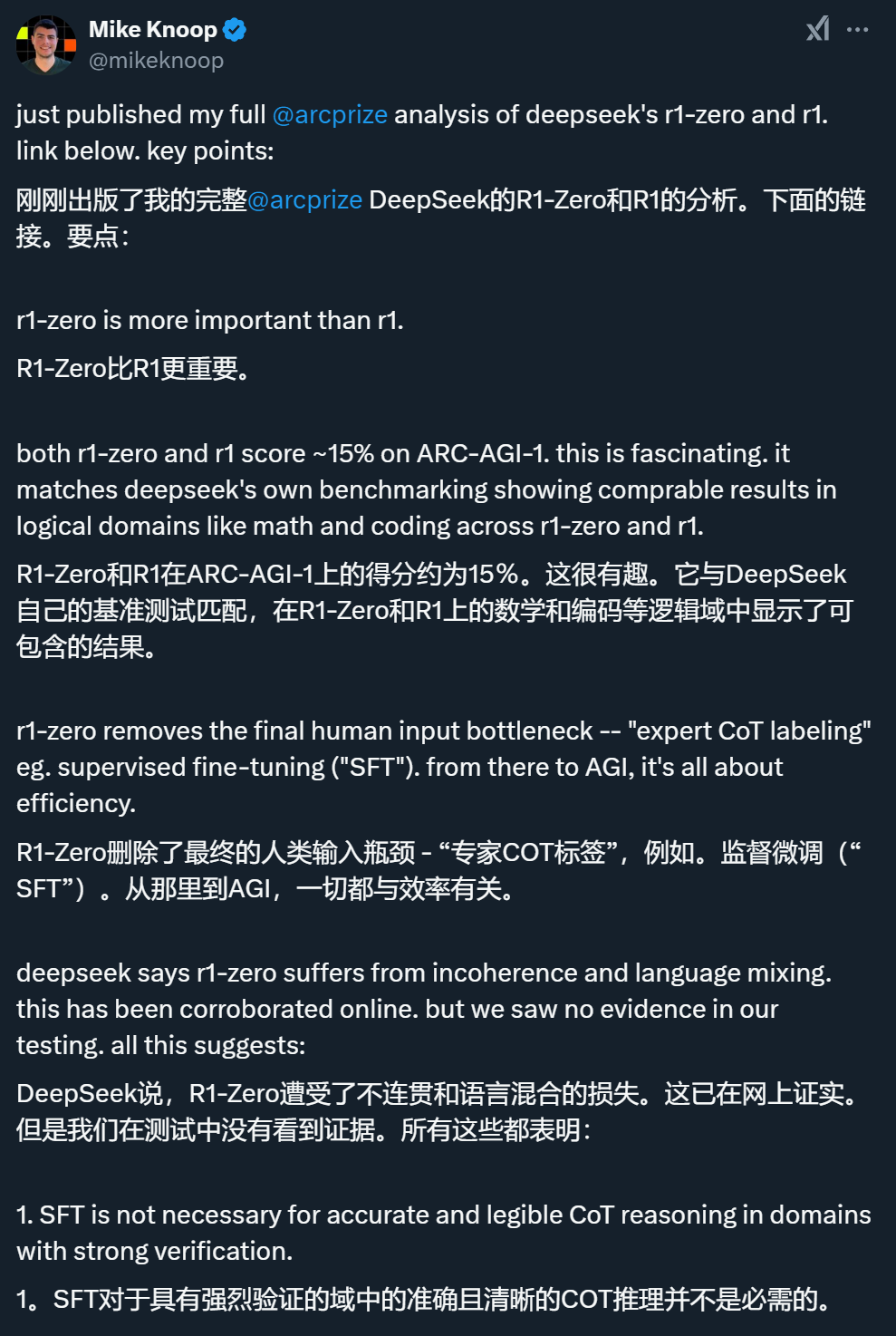

R1-Zero等模型正在打破人类数据瓶颈,开启AI自我进化新范式? 「比起R1,DeepSeek同一时间发布的R1-Zero更值得关注。」这是ARCPrize联合创始人MikeKnoop在一篇新博客中发表的观点。 他认为,R1-Zero之所以比R1更值得分析,是因为它完全依赖强化学习(RL),而不使用人类专家标注的监督微调(SFT),这表明在某些任务中,人类标注并非必要,且未来可能通过纯RL方法实现更广泛的推理能力。此外,R1和R1-Zero的成功还能让我们读出一些信息,比如:

他认为,R1-Zero之所以比R1更值得分析,是因为它完全依赖强化学习(RL),而不使用人类专家标注的监督微调(SFT),这表明在某些任务中,人类标注并非必要,且未来可能通过纯RL方法实现更广泛的推理能力。此外,R1和R1-Zero的成功还能让我们读出一些信息,比如:

通过投入更多计算资源,ai系统的准确性和可靠性可以显著提升,这将增强用户对ai的信任,推动商业化应用。

推理过程正在生成大量高质量的训练数据,且这些数据由用户付费产生,这种「推理即训练」的新范式可能彻底改变AI数据经济的运作方式,形成自我强化的循环。

以下是博客内容:?R1-Zero比R1更值得分析上周,DeepSeek发布了他们新的「推理」系统R1-Zero和R1,两个模型在ARC-AGI-1上的得分与OpenAI的o1系统低计算量版本相当。R1-Zero、R1和o1(低计算量模式)的得分都在15-20%左右。相比之下,纯LLMscaling多年积累的顶点GPT-4o仅为5%。根据本周美国市场反应,公众也开始理解纯LLMscaling的局限性。然而,对即将到来的推理需求,公众仍普遍认识不足。2024年12月,OpenAI宣布了一个经过验证的新突破性系统o3。该系统在低计算量模式下得分为76%,在高计算量模式下得分为88%。o3系统展示了计算机适应新颖未见问题的首个实用、通用实现(参见《刚刚,OpenAI放出最后大惊喜o3,高计算模式每任务花费数千美元》)。 尽管o3在ARC-AGI-1上取得胜利是重大科技新闻,但主流媒体几乎未予报道。这是AI领域和计算机科学的一个极其重要的时刻,这些系统值得研究。但由于o1/o3的封闭性质,只能依靠推测。得益于ARC-AGI-1和现在(几乎)开源的R1-Zero和R1,我们可以增进对此的理解(说「几乎」是因为DeepSeek没有发布一个可复现的方式来从头开始生成他们的模型权重)。特别是,R1-Zero比R1重要得多。在对o1和o3的分析中,ARCPrize团队针对这些推理系统的工作原理进行了推测。他们认为,这些模型的关键思路可能是:

尽管o3在ARC-AGI-1上取得胜利是重大科技新闻,但主流媒体几乎未予报道。这是AI领域和计算机科学的一个极其重要的时刻,这些系统值得研究。但由于o1/o3的封闭性质,只能依靠推测。得益于ARC-AGI-1和现在(几乎)开源的R1-Zero和R1,我们可以增进对此的理解(说「几乎」是因为DeepSeek没有发布一个可复现的方式来从头开始生成他们的模型权重)。特别是,R1-Zero比R1重要得多。在对o1和o3的分析中,ARCPrize团队针对这些推理系统的工作原理进行了推测。他们认为,这些模型的关键思路可能是:

为问题域生成思维链(CoT)。

使用人类专家(「监督微调」或SFT)和自动化机器(强化学习(RL))的组合来标注中间CoT步骤。

使用(2)得到的数据训练基础模型。

在测试时,从过程模型中进行迭代推理。

下图回顾了各模型迭代采样所使用的技术及其在ARC-AGI-1上的得分: ??????????????????图上显示的是ARC-AGI-1半私有分数。有了DeepSeek新发表的研究,ARCPrize团队可以更好地为自己的猜测提供信息。这里的关键见解是,LLM推理系统实现更高程度地适应新任务的能力(和可靠性)是通过三个维度实现的:

??????????????????图上显示的是ARC-AGI-1半私有分数。有了DeepSeek新发表的研究,ARCPrize团队可以更好地为自己的猜测提供信息。这里的关键见解是,LLM推理系统实现更高程度地适应新任务的能力(和可靠性)是通过三个维度实现的:

在CoT过程模型训练中添加人类标签(即SFT);

使用CoT搜索而不是线性推理(并行逐步CoT推理);

整体CoT采样(并行轨迹推理)。

维度1受限于人类数据生成,并限制了这些推理系统在哪些领域收益最大。例如,o1在MMLU专业法律类别上的表现出人意料地比数学和逻辑要低得多。维度2、3受限于效率。o1和o3在测试时都显示了随着推理计算量的增加,在ARC-AGI-1上的基准准确率呈对数增长,而不同的计算资源分配策略会影响达到同样性能水平所需要的具体计算量。在该团队看来,DeepSeek最有趣的做法是单独发布R1-Zero。R1-Zero是一个不使用SFT(维度1)的模型,而是完全依赖于强化学习。R1-Zero和R1在ARC-AGI-1上的得分高度一致,分别为14%和15.8%。DeepSeek自己报告的基准测试分数也显示R1-Zero和R1高度一致,例如在MATHAIME2024上的得分分别为71%和76%(相比基础DeepSeekV3的约40%有所提升)。在论文中,R1-Zero的作者提到「DeepSeek-R1-Zero面临可读性差、语言混杂等挑战」,这一点已在网上得到证实。然而在测试中,ARCPrize团队在测试R1-Zero在ARC-AGI-1上的表现时几乎没有发现不连贯的证据,这与系统经过RL训练的数学和代码领域相似。综合这些发现,ARCPrize团队得出结论:在那些能够清晰判断对错的领域中,SFT(如人类专家标注)对于准确和易读的CoT推理并非必需。

R1-Zero训练过程能够通过RL优化在token空间中创建自己的内部领域特定语言(DSL)。

SFT是提高CoT推理领域泛化性的必要条件。

这很符合直觉,因为语言本身实际上就是一个推理DSL。完全相同的「词语」可以在一个领域中学习并应用到另一个领域,就像程序一样。纯RL方法还不能发现广泛共享的词汇表,预计这将成为未来研究的重点。最终,R1-Zero展示了一个潜在scaling机制的原型,该机制完全没有人类瓶颈——甚至在训练数据获取本身也是如此。几乎可以肯定的是,DeepSeek已将目标对准了OpenAI的o3系统。重要的是要关注SFT是否最终会成为添加CoT搜索和采样的必要条件,或者假设的「R2-Zero」是否可能沿着相同的对数准确率与推理scaling曲线存在。基于R1-Zero的结果,ARCPrize团队认为在这个假设的scaledup版本中,要在ARC-AGI-1上挑战成功并不需要SFT。烧钱换信任:AI可靠性被标价从经济角度来看,AI领域正在发生两个重大转变:现在可以花更多钱来获得更高的准确性和可靠性;

训练成本正在转向推理成本。

这两者都将推动对推理的大量需求,而且都不会抑制对更多计算能力的需求。实际上,它们将增加对计算能力的需求。AI推理系统带来的价值远不止提高基准测试的分数那么简单。阻碍更多AI自动化使用(例如推理需求)的首要问题是可靠性。ARCPrize团队与数百位试图在业务中部署AI智能体的Zapier客户交谈,反馈高度一致:「我还不信任它们,因为它们工作不可靠」。此前ARCPrize团队认为,模型在ARC-AGI方面的进展将提高可靠性。LLM智能体的挑战在于它们需要强大的本地领域引导才能可靠工作。更强的泛化能力需要适应未见情况的能力。现在有证据表明ARCPrize团队的观点是正确的。因此,多家公司(Anthropic、OpenAI、Apple等)现在推出智能体也就不足为奇了。 出于可靠性需求,智能体将推动近期推理需求的显著增长。更广泛地说,开发者可以选择花费更多计算来增加用户对系统的信任。提高可靠性并不代表能做到百分百正确,但至少能保证即使犯错,也是以一种可预期的方式犯错。这没有问题,因为当准确率低时,用户和开发者现在可以通过提示更自信地引导行为。以前计算机无法解决的问题现在都有了对应的价格标签。随着效率的提高,这些价格会降低。推理即训练:推理将成AI模型的「数据永动机」??另一个正在发生的重大转变是进入LLM系统预训练的数据来源。此前,大多数数据要么是购买的,要么是抓取的,要么是从现有LLM合成生成的(例如蒸馏或增强)。这些推理系统提供了一个新选择,即生成「真实」数据而不是「合成」数据。AI行业使用「合成」一词来指代通常通过LLM循环来增加整体训练数据量的低质量数据,但收益递减。?但现在,通过推理系统和验证器,我们可以创造全新的、有价值的训练数据。这种数据的产生有两种方式:要么是开发者提前付费生成,要么是在用户实际使用系统时由用户付费生成!?这是一个引人深思的经济模式转变,暗示着拥有最多付费用户的AI系统开发商可能会拥有一个实力快速积累的关键时刻。这些付费用户实际上在为创造新的高质量数据买单..……这些数据又会让模型变得更好..……更好的模型会吸引更多用户青睐..……如此形成良性循环。?如果能够突破人类专家CoT障碍,创建一个极其高效的系统,通过搜索/合成和验证来创建新数据,那么应该预期会有大量计算投入这些推理系统,因为它们实际上只需要输入资金和原始数据就能变得更好。最终,这种类型的AI训练将完全超越在人类生成数据上进行的预训练。结论:DeepSeek推动了科学的前沿随着推理需求增加变得明显,市场调整将继续发生。AI系统效率只会推动更多使用,这不仅是由于杰文斯悖论,还因为效率提高时新的训练机制被解锁(注:杰文斯悖论指的是:当技术进步提高了资源使用效率时,反而可能导致该资源的总消耗量增加,而不是减少)。随着R1的开源和可复现,更多人和团队将把CoT和搜索推向极限。这将更快地告诉我们前沿实际在哪里,并将推动一波创新浪潮,增加快速实现AGI的机会。已经有多人告诉ARCPrize团队,他们计划在ARCPrize2025中使用R1风格的系统。R1的开源对世界来说是一件好事。DeepSeek推动了科学的前沿。原文链接:

出于可靠性需求,智能体将推动近期推理需求的显著增长。更广泛地说,开发者可以选择花费更多计算来增加用户对系统的信任。提高可靠性并不代表能做到百分百正确,但至少能保证即使犯错,也是以一种可预期的方式犯错。这没有问题,因为当准确率低时,用户和开发者现在可以通过提示更自信地引导行为。以前计算机无法解决的问题现在都有了对应的价格标签。随着效率的提高,这些价格会降低。推理即训练:推理将成AI模型的「数据永动机」??另一个正在发生的重大转变是进入LLM系统预训练的数据来源。此前,大多数数据要么是购买的,要么是抓取的,要么是从现有LLM合成生成的(例如蒸馏或增强)。这些推理系统提供了一个新选择,即生成「真实」数据而不是「合成」数据。AI行业使用「合成」一词来指代通常通过LLM循环来增加整体训练数据量的低质量数据,但收益递减。?但现在,通过推理系统和验证器,我们可以创造全新的、有价值的训练数据。这种数据的产生有两种方式:要么是开发者提前付费生成,要么是在用户实际使用系统时由用户付费生成!?这是一个引人深思的经济模式转变,暗示着拥有最多付费用户的AI系统开发商可能会拥有一个实力快速积累的关键时刻。这些付费用户实际上在为创造新的高质量数据买单..……这些数据又会让模型变得更好..……更好的模型会吸引更多用户青睐..……如此形成良性循环。?如果能够突破人类专家CoT障碍,创建一个极其高效的系统,通过搜索/合成和验证来创建新数据,那么应该预期会有大量计算投入这些推理系统,因为它们实际上只需要输入资金和原始数据就能变得更好。最终,这种类型的AI训练将完全超越在人类生成数据上进行的预训练。结论:DeepSeek推动了科学的前沿随着推理需求增加变得明显,市场调整将继续发生。AI系统效率只会推动更多使用,这不仅是由于杰文斯悖论,还因为效率提高时新的训练机制被解锁(注:杰文斯悖论指的是:当技术进步提高了资源使用效率时,反而可能导致该资源的总消耗量增加,而不是减少)。随着R1的开源和可复现,更多人和团队将把CoT和搜索推向极限。这将更快地告诉我们前沿实际在哪里,并将推动一波创新浪潮,增加快速实现AGI的机会。已经有多人告诉ARCPrize团队,他们计划在ARCPrize2025中使用R1风格的系统。R1的开源对世界来说是一件好事。DeepSeek推动了科学的前沿。原文链接:

以上就是为什么说DeepSeek的R1-Zero比R1更值得关注?的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略