在追求技术前沿的征途中,谷歌推出了“AI Edge Gallery”,这一创新平台标志着人工智能技术迈入了一个新的纪元。AI Edge Gallery精心设计,专为智能手机用户打造,它颠覆了传统认知,使得复杂的AI模型能够在手机上无需连接网络即可流畅运行。这一突破性的进展,不仅极大地扩展了AI应用的边界,也为用户隐私保护提供了更加坚实的基石。现在,无论是图像识别、语音处理还是个性化推荐,用户都能在手掌之间,享受由谷歌先进AI技术驱动的即时、高效且私密的服务。这不仅是技术的一小步,更是用户体验上的一大跃进,开启了移动设备智能化的新篇章。

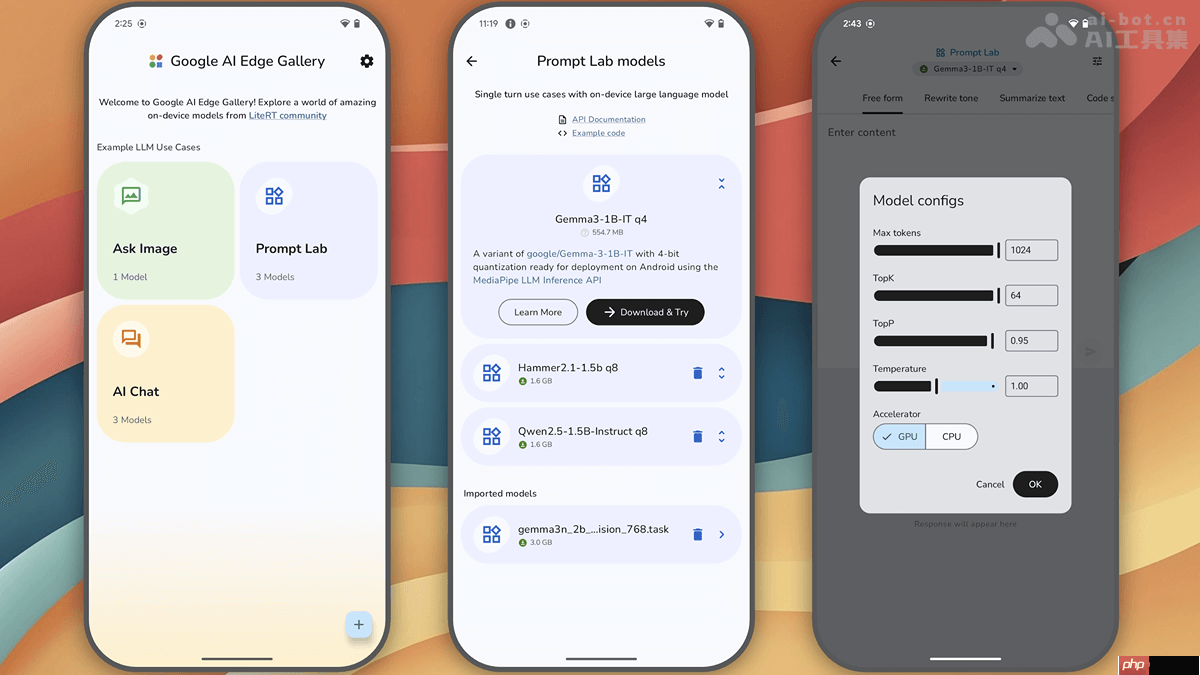

googleaiedgegallery是谷歌推出的一款试验性应用程序,允许用户在本地设备上尝试和运用机器学习(ml)以及生成式人工智能(genai)模型。此应用当前兼容android设备,并且能够在没有网络连接的情况下运行。用户可以切换不同的模型来执行图像问答、文本生成、多轮对话等任务,并且能够即时查看各项性能指标。该应用还支持自带模型的测试,为开发者提供了大量的资源和工具,以帮助他们探索设备端ai的强大能力。

GoogleAIEdgeGallery的主要功能

GoogleAIEdgeGallery的主要功能以上就是GoogleAIEdgeGallery—谷歌推出的AI应用,支持手机端离线运行AI模型的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点

最新攻略

最新攻略