在人工智能领域不断探索的前沿,复旦大学与上海AI Lab联合发布了一项创新成果——MHA2MLA技术,旨在革新大型语言模型(LLM)的推理效率。这项技术的诞生,标志着在加速AI推理过程,提高计算资源利用方面迈出了重要一步。随着对LLM应用需求的激增,传统方法在处理复杂自然语言任务时面临的效率瓶颈日益凸显。MHA2MLA通过巧妙的算法优化和架构创新,有效降低了计算成本,提升了响应速度,为智能问答、文本生成等应用场景带来了革命性的性能提升。这一突破不仅展示了国内科研机构在AI基础研究领域的深厚实力,也为全球AI发展贡献了来自东方的智慧方案。

mha2mla:高效微调transformer模型的利器

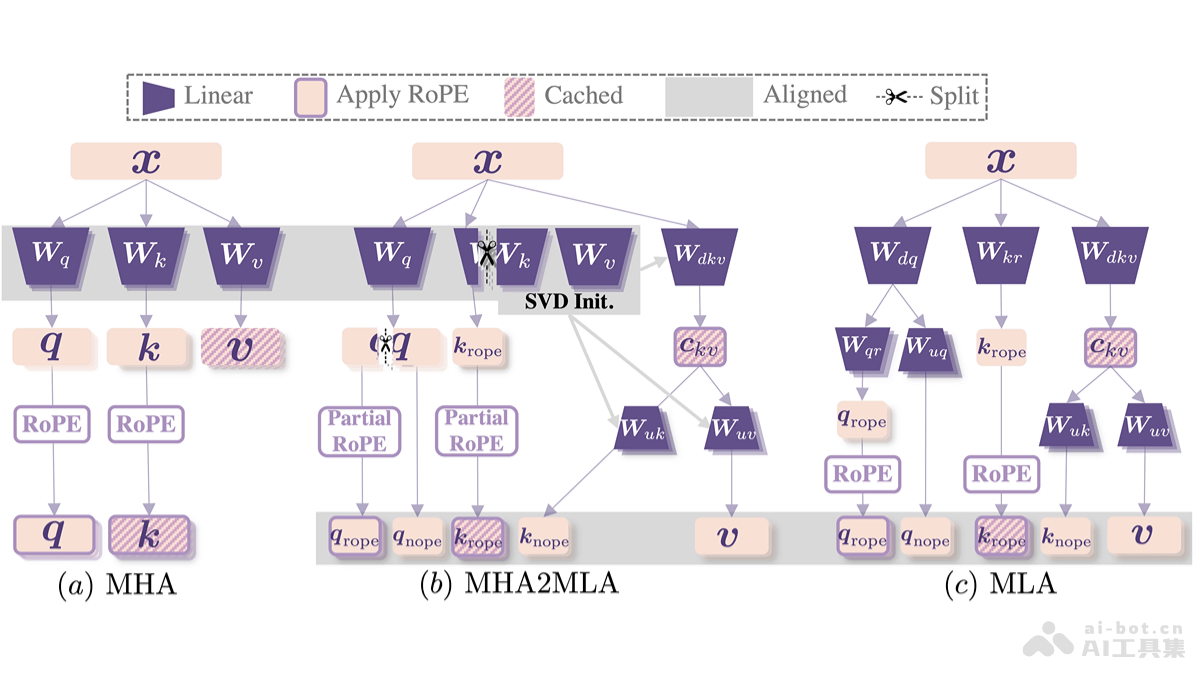

MHA2MLA是由复旦大学、华东师范大学和上海AILab等机构联合研发的一种数据高效的微调方法,它能够显著提升基于Transformer的大型语言模型(LLM)的推理效率,并降低推理成本。该方法的核心在于引入DeepSeek的多头潜在注意力机制(MLA),并通过两个关键策略实现:部分旋转位置编码(Partial-RoPE)和低秩近似(Low-RankApproximation)。

核心功能与优势:

大幅缩减KV缓存:通过低秩压缩技术,最大程度地减少KV缓存大小(最高可达96.87%),有效降低内存占用。 性能损耗极低:仅需使用原始数据的0.3%到0.6%进行微调,即可将性能损失控制在极小范围内(例如,LongBench性能仅下降0.5%)。 兼容性强:可与量化技术(如4-bit量化)结合使用,进一步提升推理效率。 数据高效:在资源受限的环境下,也能快速完成从多头注意力机制(MHA)到MLA的架构转换。技术原理详解:

MHA2MLA的效率提升主要源于以下两项技术:

Partial-RoPE:旋转位置编码(RoPE)在MHA中用于编码位置信息。Partial-RoPE通过分析每个维度对注意力分数的贡献,移除贡献较小的维度,从而减少计算和内存开销,同时保留关键位置信息。 低秩近似(Low-RankApproximationwithJointSVD):MLA利用低秩近似来压缩键值矩阵(KV),减少内存占用。MHA2MLA采用联合奇异值分解(JointSVD)对键和值矩阵进行联合分解,而非分别处理,从而更好地保留键值间的交互信息,并实现更有效的压缩。项目信息与应用场景:

GitHub仓库: arXiv论文:MHA2MLA的应用场景广泛,包括:

边缘设备部署:适用于资源受限的智能终端和物联网设备。 大规模模型推理:降低硬件成本和能耗。 结合量化技术:进一步优化推理性能,适用于实时应用场景,如实时对话和在线翻译。 长文本处理:有效缓解长文本任务的内存瓶颈。 快速模型迁移:降低模型迁移成本。总而言之,MHA2MLA提供了一种高效且经济的微调方法,为在各种资源受限的环境中部署和使用大型语言模型提供了强有力的支持。

以上就是MHA2MLA—复旦、上海AILab等推出优化LLM推理效率的方法的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点