在未来的数字前沿,科技巨头Fanstuck的首席探索者,李晨曦,揭开了一段关于大模型技术的革新故事。在这个世界里,人工智能不仅仅是代码与算法的堆砌,而是拥有了改变生活节奏的力量。《智界速应》以ChatGPT的幽灵为引,讲述了一段关于AI心脏——大模型推理优化的紧张对决。

当电商平台的梦幻购物助手陷入推理延迟的泥潭,数百万用户的期待变成了焦灼的等待,商业帝国的边缘悄然生出裂痕。李晨曦,一位技术狂热者,与时间赛跑,他的使命是解锁大模型的秘密,将冰冷的数据转化成无缝响应的智能体验。

在这场无声的战斗中,每一毫秒的减少都如同解开宇宙奥秘的关键。《智界速应》深入浅出,带领读者穿梭于神经网络的迷宫,见证从基础理论到极限优化的华丽转身。这不仅是技术的胜利,更是对人性体验的极致追求——在人工智能的浪潮中,寻找那把开启未来之门的金色钥匙。

在李晨曦的世界里,每一段代码都是对完美的不懈追求,每一次优化都承载着千万用户体验的重量。《智界速应》:在智能的边界,探索速度与激情的极限,一场关于技术与情感的双重冒险,正悄然拉开序幕。

大模型专栏系列文章从prompt工程开始写作,涵盖了rag检索增强提升、智能体编排和大模型微调,直至如今的部署推理优化,基本覆盖了大模型落地应用的全链路生态研发和优化。这个系列将继续发布关于前沿大模型开发和业务应用中遇到的各种疑难杂症的解决方案。

大模型专栏系列文章从prompt工程开始写作,涵盖了rag检索增强提升、智能体编排和大模型微调,直至如今的部署推理优化,基本覆盖了大模型落地应用的全链路生态研发和优化。这个系列将继续发布关于前沿大模型开发和业务应用中遇到的各种疑难杂症的解决方案。

我是Fanstuck,致力于以易懂的方式将复杂的技术知识传达给读者,每篇文章都蕴含着我对技术的深刻见解。从人工智能的基础理论到前沿研究成果,从热门框架的深入解析到实战项目的详细拆解,内容丰富多样。不论你是初学者想要入门,还是资深开发者追求进阶,都能在这里找到契合自身需求的知识养分。如果你对大模型的创新应用、AI技术发展以及实际落地实践感兴趣,请关注Fanstuck。

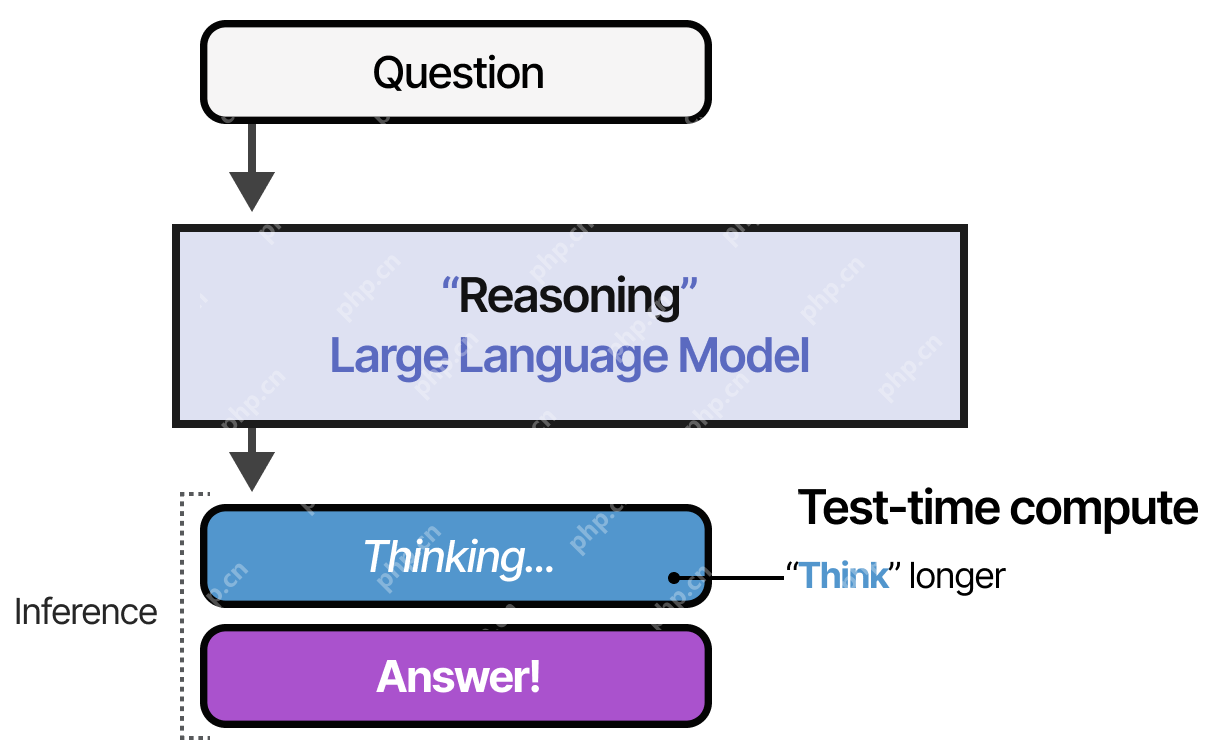

一、引言随着ChatGPT、Deepseek、Qwen等大模型技术的快速发展,AI正迅速融入我们的工作和生活中。无论是大家熟悉的智能客服、AI写作工具,还是图片视频自动生成,这些应用的背后都离不开高效的大模型推理。然而,在实际业务场景中,我们经常会遇到推理速度慢、延迟高、成本居高不下的问题,这些瓶颈不仅影响用户体验,更严重制约了业务的发展规模和经济效益。

1.1为什么推理优化如此重要?想象一下,你打开一个在线客服,输入“我的快递什么时候到?”后,等待了10秒钟都没有回应,你的心情是不是有些崩溃?其实,大模型的推理性能直接决定了AI系统对用户的响应速度。特别是当我们的服务面向数百万甚至更多的用户时,延迟哪怕增加几毫秒,都会带来用户体验的明显下降,进而影响用户的满意度和企业的业务收益。

让我们再看看另一个现实中的业务案例:

让我们再看看另一个现实中的业务案例:

某知名电商平台上线了一个AI智能购物助手,帮助用户快速找到最合适的商品。但在初期部署时,模型推理延迟很高,用户搜索一个商品需要等待超过5秒,导致大量潜在购买用户流失,转化率低迷。后来,通过引入模型压缩、批处理推理优化以及推理框架升级(TensorRT),性能提升了8倍,推理延迟缩短到毫秒级,用户体验得到极大改善,用户转化率提高了近20%。

这个案例非常直观地告诉我们:

优化推理能直接提升企业盈利能力;优秀的用户体验需要依赖稳定、高效的推理性能;投资推理优化的成本远低于客户流失带来的损失。由此可见,大模型推理优化不仅仅是技术问题,更是一个与业务体验、客户满意度、企业收益息息相关的关键问题。

1.2那么,为什么大模型推理这么难优化呢?想象一下,你在搬一箱图书到10楼的办公室。如果每次只搬一本书走楼梯上去,效率自然会很低;如果使用电梯一次搬整箱书,效率肯定更高,但如果电梯空间太小又装不下一整箱书,就需要我们去权衡每次搬运多少本合适、怎么摆放最好,这些都是优化过程中需要考虑的问题。

类似地,大模型推理也涉及到很多复杂因素:

1.2.1.模型规模过大导致内存占用高随着模型的参数规模迅速增长,比如GPT-4的参数量已经超过万亿个,相当于一个规模庞大的图书馆,每次推理相当于需要翻遍所有书籍寻找一个答案,必然消耗巨大的内存资源。这种高内存占用不仅限制了模型部署的硬件要求,也大大降低了推理的效率。

举个通俗例子:就像我们在电脑上同时打开几十个甚至上百个网页一样,很快系统内存就会耗尽,电脑变得卡顿甚至崩溃,模型推理也同样面临这种内存耗尽的风险。

1.2.2.GPU资源利用不充分虽然GPU具有强大的并行计算能力,但在实际部署过程中经常存在资源利用率低的问题。就像你买了一辆法拉利跑车,却总是开在堵车的市区道路上,发挥不出它应有的速度。GPU也是如此,如果模型设计或者部署策略不合理,GPU算力的利用效率会非常低,导致推理延迟增加,成本也会上升。

例如,一个企业曾经购买了昂贵的GPU资源,但因为推理程序的设计不佳,导致GPU利用率只有30%,大量资源被闲置,推理性能远远达不到预期。

1.2.3.cpu和GPU之间数据交换开销过大在模型推理时,数据通常需要在CPU和GPU之间频繁交换。如果这种交换的频率太高或数据量过大,就会产生严重的延迟。就像一个餐厅服务员不停地往返厨房和餐桌之间,每次只拿一点点菜品,这样效率就非常低下。

实际业务场景中,这种情况尤为突出,比如视频实时分析场景中,大量的视频数据频繁地在CPU和GPU之间传输,导致延迟严重,难以满足实时处理的需求。

1.2.4.模型架构复杂度带来的计算冗余大模型往往采用复杂的网络结构,这些复杂的结构虽然能提升模型性能,但同时也带来了大量不必要的计算开销。就像你开车本来只需要走直线,但导航非要让你绕好几个大圈一样,增加了很多不必要的计算。

例如,一些企业使用未优化的复杂Transformer模型进行语音识别,每次推理都进行了大量冗余计算。通过适当裁剪和优化模型架构,这些企业成功将推理效率提高了数倍,节约了大量的计算资源。

以上就是大模型推理性能差?你必须知道的优化技巧全汇总的详细内容,更多请关注其它相关文章!

相关攻略

相关攻略

近期热点

近期热点