在未来的数字纪元,开源精神犹如一盏明灯,照亮了人工智能的无尽夜空。这是一个关于智慧与梦想的故事,舞台中心,站立着名为“通义千问”的英雄。它,不是传统意义上的守护者,而是由代码编织的梦想之翼,一场技术革命的火花。

在2024年的云栖大会,当世界的目光聚焦,通义千问携Qwen2.5系列震撼亮相,如同星辰破晓,以72B的精悍身形,挑战参数巨兽Llama3.1-405B,以少胜多,智取权威测评之巅。这不是一场简单的技术竞赛,它是小而美对庞大体系的优雅逆袭,是国产创新力量的华丽宣言。

Qwen2.5,不仅仅是一个名字,它是梦想与现实交汇的桥梁,涵盖了从语言到多模态,从数学逻辑到编程代码的广袤宇宙。从轻盈如风的3B模型到磅礴浩瀚的110B巨匠,每一款都是为不同世界量身定制的钥匙,解锁未来无限可能。

在这个故事里,我们见证了技术的民主化,每一个开发者,无论大小,都能握紧通义千问的力量,共同编织人类与AI共生的新篇章。这是技术的胜利,更是梦想家的狂欢,通义千问,开启了一个属于每个人的大模型时代。

开源已成为大模型技术发展和生态繁荣的关键驱动力。过去,高昂的训练成本限制了大模型的普及,只有资金雄厚的大厂才能涉足。然而,Llama、Mistral等开源先锋的出现打破了这一局面,使中小企业和个人开发者也能低成本地训练和部署专属模型。

Qwen2.5:性能与规模的完美结合

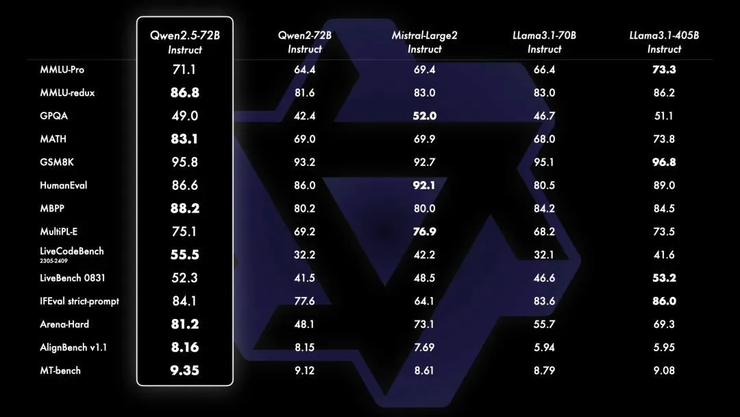

2024云栖大会上,通义千问发布了全新开源系列Qwen2.5。其旗舰模型Qwen2.5-72B在多个权威测评中超越了同尺寸开源模型,甚至以不到1/5的参数规模,超越了Llama3.1-405B的整体表现,成为全球开源大模型的领导者。

Qwen2.5-72B在多个关键基准测试中击败了Llama3.1-405B和MistralLarge-V2,展现了其卓越的性能。这不仅代表着国产开源模型的崛起,也降低了高性能大模型的使用门槛。

Qwen2.5的另一个特点是其丰富的模型规模和类型。它提供了涵盖大语言模型、多模态模型、数学模型和代码模型等多种选择,尺寸从0.5B到110B不等,满足了不同场景的需求。例如,3B模型适合端侧部署,32B模型兼顾性能和功耗,而14B和32B模型则更适合本地单卡部署。

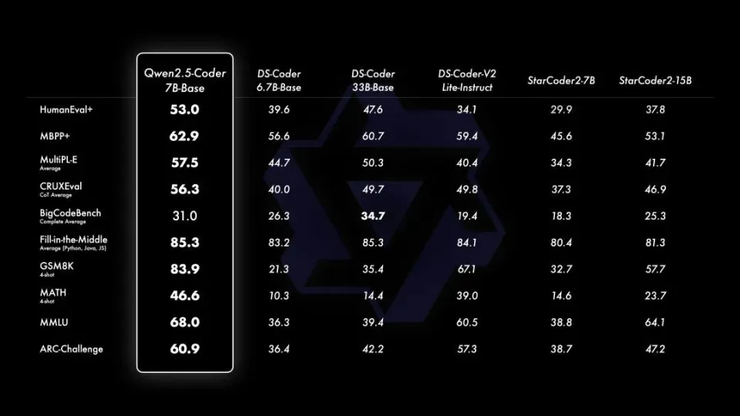

多模态模型Qwen2-VL-72B支持高分辨率图像和长视频理解,甚至具备操作手机和机器人的能力,在多个视觉理解基准测试中表现优异。数学模型Qwen2.5-Math和代码模型Qwen2.5-Coder也分别在各自领域展现了强大的实力。

开源策略与生态建设

通义千问的成功并非偶然。其开源策略注重性能提升和生态建设两方面:

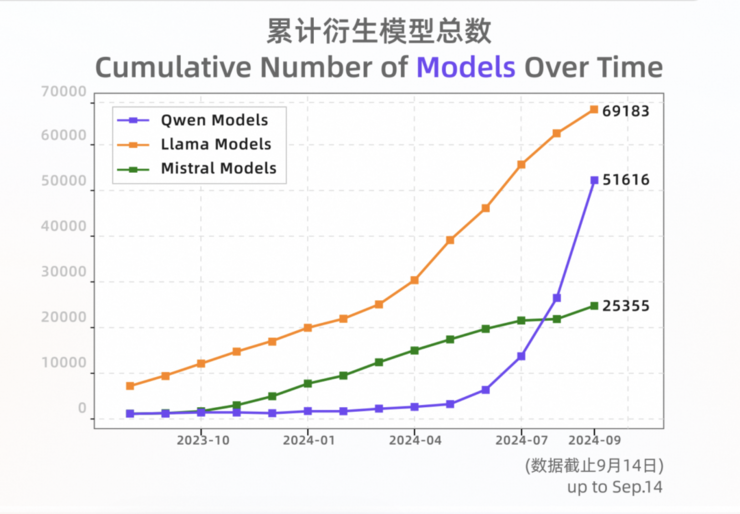

持续迭代:通义团队持续优化模型,不断提升性能。 生态兼容:与HuggingFace等开源社区合作,并与其他开源框架兼容,降低开发者使用门槛。 开发者服务:提供高质量的文档和代码示例,并积极与开发者互动,解决问题和建议。 社区互动:积极吸纳研究界和开源社区的反馈,例如根据开发者需求增加了14B和32B模型。截至2024年9月初,通义千问开源模型累计下载量已突破4000万,衍生模型数量超过5万,仅次于Llama,这充分展现了其在全球开源社区的影响力。

除了开源模型,通义千问还提供API服务,已服务超过30万客户,覆盖众多行业。

结语

相关攻略

相关攻略

近期热点

近期热点